Human #perceptron #il

#perceptron

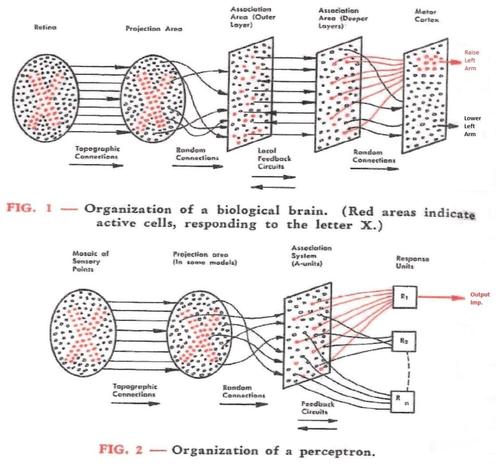

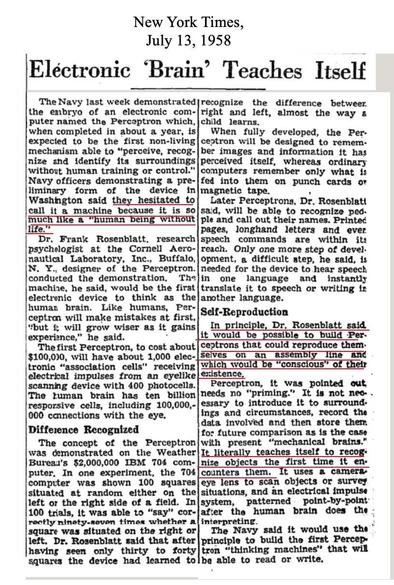

The perceptron, introduced by Frank Rosenblatt in 1957, was the first neural network model to gain wide attention. Initially hailed as a step toward machines that could “see, talk, and think,” it soon revealed limits: single-layer perceptrons could only solve linearly separable problems. After Minsky & Papert’s critique (1969), research funding dried up—until multilayer perceptrons and backpropagation revived neural networks in the 1980s.

https://en.m.wikipedia.org/wiki/Perceptron

#NeuralNetworks #Perceptron

A couple weeks ago @aeonofdiscord showed me "The Hitch-hiker's Guide to Artificial Intelligence" from 1986, a book by Richard Forsyth and Chris Naylor, which teaches readers the state-of-the-art in AI using... BASIC programming type-ins. There's some extremely minimal examples of expert systems, A* maze path search, alpha-beta game trees, etc. but one that made me curious was a "Perceptron image classifier" for machine vision. Image classification in 16kb? I had to see for myself if it would work, so I made a #Processing version. And, amazingly, it actually does - giving about 7 examples of a smile vs frown face, it can then distinguish between the two. Not bad for an idea from 1957!

На дворе LLM, а книгу о перцептроне так никто и не открыл!?

Сложно следить за околонаучными темами, и понимать, что ветка эволюции научного направления пошла не туда. Сейчас случился некий бум псевдонаучного взлета LLM, и я приведу в качестве современной статьи на хабре лишь одну, но это по прежнему массовое явление. Например, в статье компании Friflex за 2024 год История LLM-агентов: 10 ярких моментов по прежнему утверждается " На смену однослойному перцептрону Розэнблатта пришел многослойный. В статье Learning representations by back-propagating errors («Обучение представлений с помощью обратного распространения ошибки») Румельхарт и Хинтон показали, что многослойный перцептрон справляется с задачами, которые были не под силу его однослойному предшественнику. Например, с XOR. ". Совершенно излишне говорить, что это полное вранье, а авторы статьи даже не потрудились открыть эту статью, чтобы её прочитать. Это стало массовым явлением, и я его наблюдаю как минимум 20 лет, я когда то написал тут на хабре цикл статей объясняющих детали, лучше всего посмотреть эту Какова роль первого «случайного» слоя в перцептроне Розенблатта . Поэтому к этому возвращаться не будем. Я не знаю почему, может это массовая культура так влияет на людей, а порог вхождения в тематику ИИ слишком сложный? Не знаю, но не важно. Чтобы продемонстрировать скорость обучения перцептрона я написал несколько реализаций перцептрона Розенблатта и выложил их на гитхабе. А затем мы коснемся LLM.

#AI #NeuralNetworks #ANN #perceptron #military #ComputerScience

Stumbled across an article describing the ‘ADALINE’ #perceptron emulator, an analogue circuit, made entirely by a resistor and potentiometer network.

Being from the early 60’s, there’s not much information to be found these days on the device, but I managed to build it pretty much the way it was - at least I think so 😎👍🏼

It’s quite fun to train and test with different patterns - units like these are the vintage foundation of modern neural networks, AI and language models.

#LLM #AI #neuralnetworks #electronics #electronicsengineering #testandmeasurement

Pequeños y grandes pasos hacia el imperio de la inteligencia artificial

Fuente: Open TechTraducción de la infografía:

- 1943 – McCullock y Pitts publican un artículo titulado Un cálculo lógico de ideas inmanentes en la actividad nerviosa, en el que proponen las bases para las redes neuronales.

- 1950 – Turing publica Computing Machinery and Intelligence, proponiendo el Test de Turing como forma de medir la capacidad de una máquina.

- 1951 – Marvin Minsky y Dean Edmonds construyen SNAR, la primera computadora de red neuronal.

- 1956 – Se celebra la Conferencia de Dartmouth (organizada por McCarthy, Minsky, Rochester y Shannon), que marca el nacimiento de la IA como campo de estudio.

- 1957 – Rosenblatt desarrolla el Perceptrón: la primera red neuronal artificial capaz de aprender.

(!!) Test de Turing: donde un evaluador humano entabla una conversación en lenguaje natural con una máquina y un humano.

- 1965 – Weizenbaum desarrolla ELIZA: un programa de procesamiento del lenguaje natural que simula una conversación.

- 1967 – Newell y Simon desarrollan el Solucionador General de Problemas (GPS), uno de los primeros programas de IA que demuestra una capacidad de resolución de problemas similar a la humana.

- 1974 – Comienza el primer invierno de la IA, marcado por una disminución de la financiación y del interés en la investigación en IA debido a expectativas poco realistas y a un progreso limitado.

- 1980 – Los sistemas expertos ganan popularidad y las empresas los utilizan para realizar previsiones financieras y diagnósticos médicos.

- 1986 – Hinton, Rumelhart y Williams publican Aprendizaje de representaciones mediante retropropagación de errores, que permite entrenar redes neuronales mucho más profundas.

(!!) Redes neuronales: modelos de aprendizaje automático que imitan el cerebro y aprenden a reconocer patrones y hacer predicciones a través de conexiones neuronales artificiales.

- 1997 – Deep Blue de IBM derrota al campeón mundial de ajedrez Kasparov, siendo la primera vez que una computadora vence a un campeón mundial en un juego complejo.

- 2002 – iRobot presenta Roomba, el primer robot aspirador doméstico producido en serie con un sistema de navegación impulsado por IA.

- 2011 – Watson de IBM derrota a dos ex campeones de Jeopardy!.

- 2012 – La startup de inteligencia artificial DeepMind desarrolla una red neuronal profunda que puede reconocer gatos en vídeos de YouTube.

- 2014 – Facebook crea DeepFace, un sistema de reconocimiento facial que puede reconocer rostros con una precisión casi humana.

(!!) DeepMind fue adquirida por Google en 2014 por 500 millones de dólares.

- 2015 – AlphaGo, desarrollado por DeepMind, derrota al campeón mundial Lee Sedol en el juego de Go.

- 2017 – AlphaZero de Google derrota a los mejores motores de ajedrez y shogi del mundo en una serie de partidas.

- 2020 – OpenAI lanza GPT-3, lo que marca un avance significativo en el procesamiento del lenguaje natural.

(!!) Procesamiento del lenguaje natural: enseña a las computadoras a comprender y utilizar el lenguaje humano mediante técnicas como el aprendizaje automático.

- 2021 – AlphaFold2 de DeepMind resuelve el problema del plegamiento de proteínas, allanando el camino para nuevos descubrimientos de fármacos y avances médicos.

- 2022 – Google despide al ingeniero Blake Lemoine por sus afirmaciones de que el modelo de lenguaje para aplicaciones de diálogo (LaMDA) de Google era sensible.

- 2023 – Artistas presentaron una demanda colectiva contra Stability AI, DeviantArt y Mid-journey por usar Stable Diffusion para remezclar las obras protegidas por derechos de autor de millones de artistas.

Gráfico: Open Tech / Genuine Impact

Entradas relacionadas

- ¿Cómo definir la «credibilidad algorítmica»? DeepSeek da en el clavo

- Los precios dinámicos exacerban la desigualdad entre los consumidores, hay que regularlos ya

- Firma contra la vigilancia biométrica masiva

#ajedrez #alphafold2 #alphago #alphazero #aprendizajeAutomatico #articulo #artistas #aspirador #blakeLemoine #conferenciaDeDartmouth #copyright #deanEdmonds #deepBlue #deepface #deepmind #deviantart #eliza #facebook #gatos #genuineImpact #go #google #gps #gpt3 #grafico #hinton #ia #ibm #infografia #inteligenciaArtificial #irobot #jeopardy #kasparov #lamda #leeSedol #marvinMinsky #mccarthy #mccullock #midJourney #modelos #newell #openTech #openai #patrones #perceptron #pitts #plegamientoDeProteinas #predicciones #procesamientoDelLenguajeNatural #reconocimientoFacial #redesNeuronales #remezclar #robot #rochester #roomba #rosenblatt #rumelhart #shannon #shogi #simon #sistemaDeNavegacion #snar #stabilityAi #stableDiffusion #testDeTuring #turing #videos #watson #weizenbaum #williams #youtube

at 66 and past retirement age, neural-networks are still cool and futuristic ;> #ai #neuralnetworks #perceptron

We started our #ISE2024 lecture on Basic Machine Learning today with "A (very) brief History of AI", which - in the end - took longer than expected ;-) ....stories and anecdotes time again

lecture slides: https://drive.google.com/file/d/1smo2qdVbXIVWqE9JHrtD6Ao6LDj1q9Jn/view?usp=drive_link

@enorouzi @sourisnumerique @fizise @fiz_karlsruhe #AI #HistoryOfAI #perceptron #expertsystem #knowledgebase #symbolicAI #subsymbolicAI #neuralnetworks #connectivism #generativeAI #creativeAI #AIart #astronaut

Кто знает, что значит GPT в названии ChatGPT, могут дальше не читать!.

В настоящее время искусственный интеллект (ИИ) стремительно развивается. Мы являемся свидетелями интеллектуальной мощи таких нейросетей, как GPT-4 Turbo от OpenAI и Gemini Ultra от Google . В Интернете появляется огромное количество научных и популярных публикаций. Зачем же нужна еще одна статья про ИИ? Играя с ребенком в ChatGPT, я неожиданно осознал, что не понимаю значения аббревиатуры GPT. И, казалось бы, простая задача для айтишника, неожиданно превратилась в нетривиальное исследование архитектур современных нейросетей, которым я и хочу поделиться. Сгенерированная ИИ картинка, будет еще долго напоминать мою задумчивость при взгляде на многообразие и сложность современных нейросетей.

https://habr.com/ru/articles/785080/

#нейросети #нейронные_сети #cnn #rnn #трансформеры #gpt #chatgpt #gan #nlp #perceptron

Ever wondered about the role of a perceptron in neural networks? Dive into its math foundation, limitations, and practical applications. 🧠💡 #NeuralNetworks #AI #Perceptron https://ak-codes.com/perceptron/

Check out my new essay "Memorization and Memory Devices in Early Machine Learning" in Interfaces on memory in (historical) artificial neural networks: https://drive.google.com/file/d/1cQ5sjThMLqcHerm3ptwssy7U43ddlJXQ/view #ml #ai #perceptron

@glaroc It absolutely is fun, and the thing is it makes a real effort to try and teach you about real nural networks and how they really operate. And I tried. I really did. I even watched part of the video they linked. But it is so far beyond my ability to comprehend... It made me a little sad. Yet I love the game, so there. Haha. #Perceptron

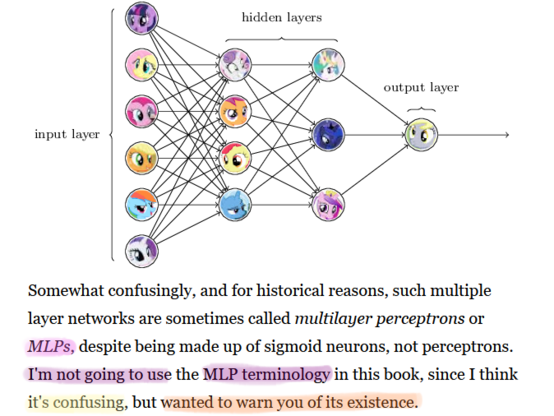

So I've started learning about basic neural networks from this website, http://neuralnetworksanddeeplearning.com/ , and in Chapter 1 of the site there's this little section that I found easily memeable... I am sorry in a way that I'm not actually sorry 😛

#mlp #mylittlepony #neuralnetworks #neuralnetwork #perceptron #sigmoidneurons #mylittleperceptrons

@remenca @spla En #Vapnik va escriure un llibre que déu n'hi do: "The nature of statistical learning theory" http://lib.ysu.am/disciplines_bk/22cca8eefb24af29d10bbc661e3a5ebf.pdf que introdueix de tot, incloguent-hi #SVM #ANN #perceptron i molt més.

Having good Git commits is a really good way to be able to do controlled experiments on your software.

For example, I changed how my asteroids AIs are mutated and crossed over. How do I know that *both* of the changes are required for high achievement?

git revert, baby.

A Course in Machine Learning

(2012) : Daum{\'e}, Hal III

url: http://ciml.info/

#bayesian #decision_tree #education #geometry #graphical_models #kernal #machine_learning #nearest_neighbours #neural_network #perceptron #probability #text_book

#my_bibtex

Java Neural Network Framework Neuroph

http://neuroph.sourceforge.net/download.html

#java_neural network #neural_network library #java_neural network framework #open_source #source_code #backpropagation #perceptron

Java Neural Network Framework Neuroph

http://neuroph.sourceforge.net/

#java_neural network #neural_network library #java_neural network framework #open_source #source_code #backpropagation #perceptron