Ich hasse #ki #scraper so sehr dafür, dass ich meine Werke mit hässlichen #Wasserzeichen und XML veröffentlichen muss… Was ein Aufwand. x_X

#wasserzeichen

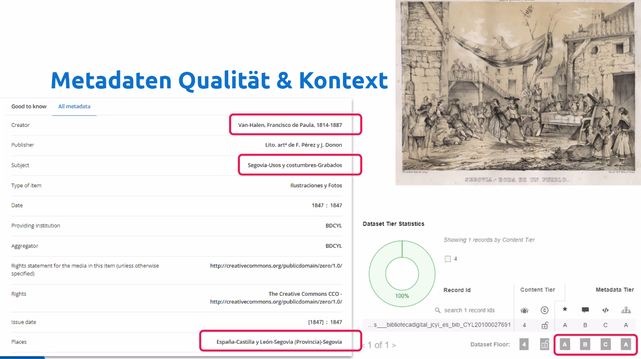

🤔 Schwierige Fälle der Qualitätsbewertung bzw. Messbarkeit, so Henning Scholz, sind z.B. die unterschiedlichen Book Viewer, Objekte mit #Wasserzeichen oder ganz grundsätzlich die Diversität der Titel und Beschreibungen.

💡 Mit der Metis Sandbox gibt es eine Testumgebung, um den Ingestion Prozess zu simulieren.

nfdi4culture.de/events/forum-measuring-the-quality-of-cultural-data-but-how-concepts-methods-potentials-and-the-nfdi4culture-approach.html

#NFDI4Culture #NFDIrocks #datenqualitat

^gp

🧠 Das Modell basiert auf einem großen Trainingsdatensatz aus Bildern und Texten und erzeugt besonders kontextbewusste, hochwertige Visualisierungen.

🛠️ Zusätzlich arbeitet #OpenAI an einer #API, mit der Entwickler eigene Anwendungen auf Basis des Bildgenerators aufbauen können.

⚙️ Ob die Einführung des #Wasserzeichen|s dauerhaft umgesetzt wird, ist noch offen, da sich OpenAI-Pläne häufig ändern.

👉 https://eicker.TV #Technik #Medien #Politik #Wirtschaft (2/2)

ChatGPT testet Wasserzeichen für generierte Bilder.

🖼️ #OpenAI testet derzeit #Wasserzeichen für das #Bildgenerierungsmodell von #ChatGPT-4o, das inzwischen auch für kostenlose Nutzer verfügbar ist.

🆓 Während Plus-Abonnenten Bilder weiterhin ohne Wasserzeichen speichern können, sollen kostenlose Nutzer künftig markierte Bilder erhalten.

🎨 Hintergrund ist die massive Nutzung des Modells für die Erstellung von Bildern im Stil von Studio Ghibli, was weltweit für Aufmerksamkeit sorgt. (1/2)

1. Vereinbarung geschlossener KI-Systeme: die eigenen Daten bleiben hier in einem "Silo".

2. #Anonymisierung der eigenen Daten: aufwändig und meistens letztlich nicht wirksam genug (verbleibende Rest-Informationen können de-anonymisiert werden).

3. Schutz der eigenen Daten vor KI-#Scraping durch #Wasserzeichen und Widerspruchs-Hinweise – leider nur sehr eingeschränkt wirksam.

Die Frage, die sich jede Organisation stellen sollte: Wie schütze ich meine IP vor "datenhungrigen" KI-Anbietern?

Hinterlistige Nutzer verwenden die neue Bildgenerierungsfunktion des KI-Modells "Gemini 2.0 Flash" von Google, um Wasserzeichen aus Bildern zu entfernen, auch von Bildern von Getty Images und anderen bekannten Stock-Media-Anbietern.

#google #ki #ai #gemini #wasserzeichen #watermark #watermarkremover #scam #bildschutz #copyright #stockimages #media

🧵 …wie oben schon mehrfach erwähnt, ignoriert KI das #Copyright-Recht bewusst:

»Gemini 2.0 Flash – KI-Tool entfernt Wasserzeichen ohne Restriktionen:

Während #Gemini 2.0 Flash üblicherweise zur Generierung von #Bilder'n genutzt wird, haben findige Nutzer eine neue #Anwendung'smöglichkeit entdeckt. Diversen Berichten zufolge lassen sich mit dem #KI-Tool auch #Wasserzeichen aus Bildern leicht entfernen. Maßnahmen, die dies verhindern sollen, besitzt die #Software nicht«

KI-generiertes mit Wasserzeichen kennzeichnen

SynthID soll Open Source werden

Mehr dazu bei https://www.zeit.de/digital/internet/2024-10/ki-generierte-medien-fotos-texte-identifikation-wasserzeichen

a-fsa.de/d/3Dv

Link zu dieser Seite: https://www.aktion-freiheitstattangst.org/de/articles/8946-20241027-ki-generiertes-mit-wasserzeichen-kennzeichnen.html

Link im Tor-Netzwerk: http://a6pdp5vmmw4zm5tifrc3qo2pyz7mvnk4zzimpesnckvzinubzmioddad.onion/de/articles/8946-20241027-ki-generiertes-mit-wasserzeichen-kennzeichnen.html

Tags: #KI-Act #AI #künstlicheIntelligenz #Wasserzeichen #Kennzeichnung #EU #Studie #Abhängigkeit #Google #SynthID #Ununterscheidbarkeit #FakeNews

@publicvoit

Das ganze hat nichts mit Adobe #DRM zu tun. Die #eBooks der Tolino-Allianz werden (Soweit mir bekannt) nur mit #Wasserzeichen versehen!

Es geht darum, dass die Website von Weltbild offline geht und danach über das Kundenkonto keine digitalen Inhalte mehr runtergeladen werden können. Man würde seine digitalen Inhalte verlieren, wenn man sie nicht lokal gespeichert hat!

Bei hartem DRM wie halt Adobe DRM wären die Inhalte jedoch rettungslos verloren!

#Tolino

Ich fordere ein digitales #Wasserzeichen für #KI-generierte Bilder.

Termintipp: Der CAST-Workshop "Künstliche Intelligenz und #Cybersicherheit" findet am 16. Mai im Fraunhofer SIT statt. Mit dabei ist unser Experte Prof. Martin Steinebach. Er stellt wissenschaftliche Ansätze zur Erkennung von #KI-basierten Manipulationen in Texten, Bildern und Videos vor sowie damit einhergehende Herausforderungen.

Mehr Informationen zur Veranstaltung und das Anmeldeformular finden Sie hier: https://cast-forum.de/workshops/programm/335?ts=1713524335725

#deepfake #KI #Wasserzeichen

Im #FraunhoferSIT findet am 16. Mai der CAST-Workshop "Künstliche Intelligenz und #Cybersicherheit" statt. Mit dabei unser Experte Prof. Martin Steinebach der in seinem Vortrag die Herausforderungen und wissenschaftlichen Ansätze zur Erkennung von #KI-basierten #Manipulationen in Mediendaten beleuchtet.

Mehr Informationen zur Veranstaltung und das Anmeldeformular finden Sie hier: https://cast-forum.de/workshops/programm/335?ts=1713524335725

#deepfake #kuenstlicheIntelligenz #Wasserzeichen

📬 TraceMark von Denuvo soll Leaker überführen

#Denuvo #Gaming #GameDeveloperConference #Irdeto #TraceMark #TraceMarkforGames #Wasserzeichen https://sc.tarnkappe.info/2ca587

Vor der US-Wahl wurde ein gefälschter Anruf mit Joe Biden veröffentlicht, der anscheinend mithilfe von KI erstellt wurde. Nun diskutieren Techfirmen die Einführung von KI-Kennzeichnungen für Inhalte. Unser Experte Prof. Martin Steinebach teilt in einem Artikel der @DIE ZEIT seine Einschätzung zu diesem Thema.

Hier kommen Sie direkt zum Artikel: https://www.zeit.de/digital/2024-02/ki-wahlkampf-joe-biden-kennzeichnung/komplettansicht

#Wasserzeichen #KI #Kennzeichnung #USA #Wahlkampf #USWahl #Biden #Tech

Erkennen wir echt vs. KI-generierte Inhalte? Der Artikel von Prof. Martin Steinebach im Tagesspiegel Background Cybersecurity diskutiert Ansätze wie digitale Wasserzeichen sowie den Wettstreit zwischen Sicherheitsmechanismen und Angreifenden.

👉 https://background.tagesspiegel.de/cybersecurity/der-richtige-umgang-mit-ki-generierten-inhalten

#KI #kuenstliche Intelligenz #Tagesspiegel #digital #digitaleWasserzeichen #Wasserzeichen

Kommen bald fälschungssichere Fotos?

Sony plant mit einer innovativen Technologie, dem aktuellen Trend der ständigen gefälschten Fotos entgegenzuwirken.

Das Sony Xperia 1 VI kann Fotos mit authentischen Wasserzeichen versehen, um Fälschungen zu verhindern.

https://www.nextpit.de/sony-xperia-1-vi-kamera-mit-wasserzeichen

Viele #KI-generierte Bilder lassen sich kaum noch als solche erkennen. Mehrere Konzerne setzen daher auf #Wasserzeichen, die sie in die Bilder einbetten. Doch es gibt erhebliche Zweifel, ob der technische Ansatz funktioniert. Im Gespräch mit @netzpolitik_feed empfehlen Fachleute, darunter unser Experte Prof. Martin Steinebach, gesellschaftliche Lösungen.. 👉 https://netzpolitik.org/2023/kuenstliche-intelligenz-mit-wasserzeichen-gegen-die-babylonische-verwirrung/

Dieser Artikel stammt von Netzpolitik.org.Der Autor ist…

Viele KI-generierte Bilder lassen sich kaum noch als solche erkennen. Mehrere Konzerne setzen daher auf Wasserzeichen, die sie in die Bilder einbetten. Doch es gibt erhebliche Zweifel, ob der technische Ansatz funktioniert. Im Gespräch mit netzpolitik.org empfehlen Fachleute gesellschaftliche Lösungen.

Der Turmbau zu Babel, ersponnen von einer KI. – Public Domain Midjourney („The tower of babel being build by robots as a painting by Pieter Bruegel“)Das Foto soll den verbrannten Leichnam eines Babys zeigen. Gepostet hatte es am 13. Oktober unter anderem der offizielle Account des Staates Israel auf X, ehemals Twitter. Das darauf abgebildete Kind soll bei dem grausamen Angriff der Hamas auf die israelische Zivilbevölkerung knapp eine Woche zuvor ums Leben gekommen sein.

Innerhalb weniger Stunden stand auf X der Vorwurf im Raum, das Bild sei mit Hilfe sogenannter Künstlicher Intelligenz generiert worden. Eine Detektor-Software hatte das Foto als Fälschung gekennzeichnet. Der Vorwurf nährte den Verdacht, die israelische Regierung verbreite gezielt Falschinformationen.

Zwei Ebenen der Desinformation

Was ist real, was ist fake? Diese Frage stellt sich in Zeiten, in denen KI-generierte Inhalte allerorten auftauchen, immer häufiger. Und immer seltener lässt sie sich klar beantworten.

Selbst Detektoren, die mit gewaltigen Mengen von KI-generierten Bildern trainiert werden, finden darauf oftmals keine eindeutige Antwort oder ihre Ergebnisse widersprechen einander. Im Fall des obigen Bildes hat sich der eingesetzte Detektor AI or Not offenbar „geirrt“, wie Hany Farid gegenüber dem US-Magazin 404 Media sagte. Farid ist Experte für digitale Bildmanipulation an der Universität Kalifornien in Berkely, und kommt nach eingehender Prüfung zu dem Schluss, dass das Bild von Menschen erstellt wurde. Die widersprüchliche Kennzeichnung durch verschiedene KI-Detektoren bezeichnet er als „zweite Ebene der Desinformation“. Das bedeutet: Nicht ein Inhalt selbst ist Desinformation, sondern seine Einstufung als Fälschung.

Die erste Ebene der Desinformation veranschaulicht exemplarisch ein anderes Foto, das im Mai dieses Jahres für Aufregung sorgte. Es zeigt angeblich eine Explosion nahe des US-amerikanischen Verteidigungsministeriums. Die KI-Fälschung wurde zwar rasch als solche identifiziert, sorgte damals aber dennoch für einen kurzzeitigen Kurseinbruch an den Börsen.

Solche Fake-Bilder bereiten Politiker:innen, Journalist:innen und Forschenden gleichermaßen Kopfzerbrechen. Denn sie können nicht nur kriegerische Auseinandersetzungen verschärfen oder Wahlen beeinflussen. Sondern sie gefährden, weil sie unser Verständnis davon unterhöhlen, was wahr ist, auch den demokratischen Diskurs.

Ein Symbol für Transparenz

Die Konzerne, die den KI-Geist aus der Flasche ließen, suchen derzeit händeringend nach Lösungen, wie sich von Menschen erstellte Inhalte besser von solchen unterscheiden lassen, die maschinell generiert sind. Die Unternehmen wollen so den potentiellen Schaden verringern, den ihre Produkte anrichten können, und eine strengere Regulierung durch die Politik vermeiden.

Der jüngste Vorschlag dazu stammt von Adobe. In der vergangenen Woche stellte das Unternehmen eine neue Technologie namens Content Credentials vor. Sie soll es ermöglichen, dass sich Nutzer:innen die Metadaten von Bildern direkt anzeigen lassen können. Dazu wird der „Content Credentials pin“ auf Bilder platziert, ein tröpfchenförmiges Symbol mit den Buchstaben CR in seiner Mitte.

Berühren Nutzer:innen das „Icon of Transparency „mit dem Mauszeiger oder ihrem Finger, werden ihnen Informationen über die Urheberschaft angezeigt oder Angaben dazu, mit welchem KI-Generator das Bild erstellt wurde. Das Icon ähnelt damit eher Nährwertangaben auf Lebensmitteln als einem Wasserzeichen, schreibt Adobe in einem Blogbeitrag.

Das Content Credential entstand in Zusammenarbeit mit anderen Unternehmen in der Coalition for Content Provenance and Authenticity (C2PA). Der Gruppe gehören neben Adobe auch Microsoft, Nikon, Leica und der französische Werbedienstleister Publicis Groupe an. Sie wollen das Symbol fortan ebenfalls in ihren Produkten verwenden.

Freiwillige Selbstverpflichtung der Konzerne

Das Content Credential geht auch auf ein Versprechen der Techkonzerne zurück. Im September dieses Jahres sagten unter anderem Adobe, IBM und Nvidia US-Präsident Joe Biden zu, KI-generierte Inhalte mit Wasserzeichen kenntlich zu machen. Amazon, Google, Meta, Microsoft und OpenAI hatten dem Weißen Haus bereits einige Wochen zuvor im Rahmen einer freiwilligen Selbstverpflichtung eine ähnliche Zusage gegeben.

Microsoft und OpenAI hatten bereits vor Adobes jüngster Ankündigung damit begonnen, sichtbare Wasserzeichen – sogenannte „manifeste Signaturen“ – in den Ecken der Bilder zu platzieren, die ihre KI-Systeme generieren. OpenAI hatte mit seinem Textgenerator ChatGPT und dem Bildgenerator Dall-E maßgeblich den KI-Hype ausgelöst.

Andere Konzerne wie Alphabets Tochterfirma Deepmind nutzen hingegen Wasserzeichen, die für das menschliche Auge unsichtbar sind. Derzeit testet Deepmind ein eigenes System namens SynthID, das Bilder entsprechend kennzeichnet, die der hauseigene Bildgenerator Imagen erstellt.

Im Englischen werden diese Markierungen als „low perturbation watermarks“ bezeichnet – zu Deutsch: Wasserzeichen mit geringem Störfaktor. Sie seien auch dann noch nachweisbar, wenn Bilder manipuliert oder in anderen Formaten gespeichert werden, so Deepmind.

Das Ziel sei es, ein System zu schaffen, bei dem die meisten KI-Bilder durch eingebettete Wasserzeichen leicht identifiziert werden können, sagte Pushmeet Kohli, Vizepräsident für Forschung bei Google Deepmind, gegenüber der Washington Post. SynthID befinde sich derzeit in der Testphase und funktioniere noch nicht fehlerfrei. „Die Frage lautet: Haben wir überhaupt die Technologie, um das Ziel zu erreichen?“, so Kohli.

KI mit KI bekämpfen

Ebendiese Frage stellt sich auch der Informatiker Martin Steinebach. Er leitet die Abteilung Media Security und IT Forensics am Fraunhofer-Institut für Sichere Informationstechnologie. „Digitale Wasserzeichen gibt es seit vielen Jahren und nun erfahren sie so etwas wie eine Renaissance“, sagt Steinebach auf Anfrage von netzpolitik.org.

Allerdings stelle es eine große technische Hürde dar, dass Wasserzeichen erhalten bleiben, wenn Bilder skaliert oder komprimiert werden. Gerade bei der Verkleinerung würden Bilder und damit auch Wasserzeichen an Qualität einbüßen. „Darüber hinaus werden die Werkzeuge immer mächtiger, mit denen sich sichtbare Wasserzeichen aus Bildern entfernen lassen“, so Steinebach. Viele dieser Tools sind im Internet nur einen Mausklick entfernt.

Zwei aktuelle Studien bestätigen Steinebachs Sorge. Die erste stammt von Soheil Feizi und weiteren Autor:innen. Feizi ist Professor für Informatik an der Universität Maryland. Die Forschenden zeigen auf, wie vergleichsweise leicht sich Wasserzeichen aus KI-generierten Bildern „auswaschen“ lassen. Genauso einfach sei es, Wasserzeichen in menschlich generierte Bilder einzufügen und sie somit als vermeintliche Fake-Inhalte zu kennzeichnen. Die Studie kommt zu dem Schluss, „dass die Entwicklung eines robusten Wasserzeichens eine anspruchsvolle, wenn auch nicht unmögliche Aufgabe ist“.

Die zweite Studie von Forschenden der Universitäten Kalifornien, Santa Barbara und Carnegie Mellon, Pennsylvania ist noch pessimistischer. Sie schätzt alle derzeit genutzten unsichtbaren Wasserzeichen als unsicher ein. Verantwortlich dafür sei ausgerechnet KI. Es sei geradezu ironisch, so die Forschenden, dass „die jüngsten Fortschritte bei generativen Modellen, die den dringenden Bedarf an unsichtbaren Wasserzeichen verursacht haben, auch die Entfernung von Wasserzeichen erleichtern“.

Für Martin Steinebach ist das kein Grund, die Flinte ins Korn zu werfen: „Watermarking ist nicht gleich wirkungslos, nur weil es eine Gegenstrategie gibt“, sagt er. Auch die Digitale Rechteverwaltung (DRM) bei digitalen Medien sei oftmals leicht zu knacken. Dennoch böte DRM weiterhin Schutz „vor missbräuchlichen Kopien“ etwa bei E-Books oder Computerspielen.

Wir brauchen mehr als technische Lösungen

Der Kryptograf David Niehues von der Universität Wuppertal ist überzeugt, dass wir mehr als technische Lösungen benötigen. „Zunächst müssen wir lernen, damit umzugehen, dass uns Bilder vorliegen, die zwar echt aussehen, die aber falsch sind“, sagt Niehues gegenüber netzpolitik.org.

„Darüber hinaus brauchen wir gesellschaftliche Lösungen“, sagt der Informatiker. Da wir uns nach wie vor in einer Welt mit Gatekeepern bewegen, könnten etwa Redaktionen von Qualitätsmedien die erforderlichen Verifikationen vornehmen. „Dafür aber braucht es Vertrauen in deren Fachkenntnis, Arbeitsweise und Unabhängigkeit. Besteht dieses Vertrauen, dann könnten sie uns dabei helfen, die Spreu vom Weizen zu trennen“, so der Informatiker.

Dass wir als Gesellschaft dazulernen müssen, glaubt auch Jutta Jahnel. Sie ist wissenschaftliche Mitarbeiterin der Forschungsgruppe „Digitale Technologien und gesellschaftlicher Wandel“ am Karlsruher Institut für Technologie. „Wir müssen die Dinge vorsichtiger wahrnehmen“, sagt sie, „dazu bedarf es einer neuen grundsätzlichen Skepsis und Kritikfähigkeit.“

Vor allem aber begrüßt es Jahnel, dass die Europäische Union derzeit die KI-Verordnung verhandelt. „Rechtlich passiert bisher noch zu viel im Rahmen von Selbstverpflichtungen“, sagt Jahnel. Das EU-Gesetz soll Künstliche Intelligenz europaweit regulieren und befindet sich aktuell im Trilog. Dort ringen Kommission, Rat und Parlament unter anderem um die Frage, wie strikt die Vorschriften für sogenannte „general purpose AI“ ausfallen sollten, also KI-Systeme, die sich aufgrund ihrer Fähigkeit sehr vielseitig einsetzen, aber auch missbrauchen lassen.

Mit modernen KI-Systemen lassen sich auch fotorealistisch aussehende Bilder generieren. Daher sollte das Risiko, das von dieser Technologie ausgeht, nicht unterschätzt werden, sagt Jahnel. „Denn wenn wir nicht mehr genau sagen können, was wahr ist und was nicht, schafft das eine babylonische Verwirrung. Und dies wirkt sich wiederum negativ auf den gesellschaftlichen Diskurs und die Demokratie aus.“ In der biblischen Erzählung vom Turmbau zu Babel verwirrt Gott die Sprache der Menschen, sodass sie sich nicht mehr verständigen können. Wie berechtigt die Sorge vor einer Verwirrung durch generative KI ist, hat sich in der vergangenen Woche einmal mehr deutlich gezeigt.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen. Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Zur Quelle wechseln

Zur CC-Lizenz für diesen Artikel

Author: Daniel Leisegang

#babylonische #gegen #intelligenz #kunstliche #verwirrung #wasserzeichen

Google SynthID ist ein technischer Ansatz, der Menschen + Organisationen hilft, verantwortungsbewusst mit KI-generierten Inhalten umzugehen.

#AI #SynthID #KI #Imagen #GoogleCloud #EthischeKI #AIgenerierterInhalt #Wasserzeichen #Metadaten

https://kinews24.de/google-synthid-ki-generierte-bilder-muehelos-identifizieren

Tipps zur #Wasserzeichen-Funktion in #Word und im #LibreOffice #Writer. Inklusive #Workaround zur fehlenden #Bildwasserzeichen-Funktion im Writer.

https://www.pctipp.ch/praxis/office/wasserzeichen-in-word-libreoffice-writer-2000083.html