🌖 OpenAI 微調工具 – 使用 Google Sheets 數據打造 AI 模型

➤ 利用 Google Sheets 輕鬆打造專屬 AI 模型

✤ https://promptrepo.com/finetune/

Promptrepo 提供一個無需程式碼的平臺,讓使用者能利用 Google Sheets 中的數據來微調 OpenAI、Mistral 或 LLaMA 等 AI 模型。它提供多種功能,包括建立分類、提取和生成式 AI 模型,並支援 API 整合、版本控制、以及多種 Google Forms 擴充功能,如表單客製化、電子簽名、檔案上傳等,旨在簡化 AI 模型開發流程,並賦能領域專家參與 AI 模型的創建。

+ 哇,這真的太方便了!我一直想訓練自己的 AI 模型,但程式碼對我來說是個障礙。這個工具簡化了整個過程,讓我非常興奮!

+ 這個平臺整合了許多實用功能,不僅能微調 AI 模型,還能直接應用到 Google Forms 中,這對於收集和分析數據來說非常有效率。

#人工智慧 #Google Sheets #微調 #Promptrepo

#%E5%BE%AE%E8%AA%BF

周軼君 在敏感與鈍感中不斷微調

https://www.headline01.com/a/rqnoAZ1lN9VNf9dvGKIWaQ-85CB4678.html

#微調 #敏感

有航司想當西南航空的“平替”? |小黃精神航空破產的後續| 中美直航兩個微調)

https://www.headline01.com/a/DUErNPV-OWY7rFEyV34rDw-EF7B77FE.html

#小黃 #後續 #微調

不花一分錢!GPT-4o微調限時免費開放,每日附贈百萬訓練token

https://www.headline01.com/a/HdMUK9qHAOGLbL1UBkexcg-9736877E.html

#一分錢 #微調 #開放

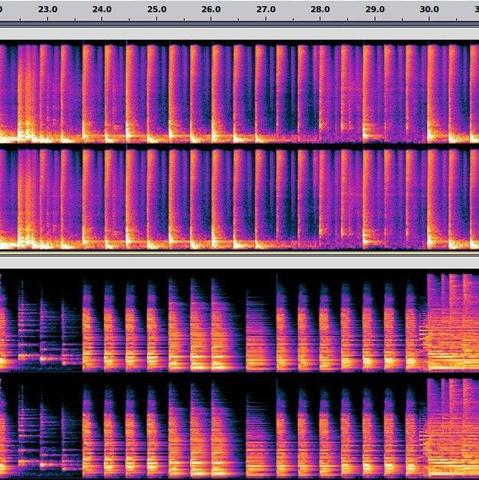

Stable Audio ControlNet:基於DiT ControlNet的Stable Audio Open微調工具

https://www.headline01.com/a/FBpVWwq1wiZr6ipCfTceBg-9DE14F36.html

#工具 #微調

ICML 2024高分論文 | 零階優化器微調大模型,大幅降低內存

https://www.headline01.com/a/-ABGtqsG9IbdRNpxZDETCA-147499C6.html

#微調 #模型 #記憶體 #論文

🌘 在網際網路上對大型語言模型進行分散推理和微調

➤ 大型語言模型的成本效益推理和微調

✤ https://browse.arxiv.org/html/2312.08361v1

在研究中,我們探討了以成本效益推理和微調大型語言模型(LLMs)的方法,比較了本地和分散策略。我們觀察到,一個足夠大的模型(50B+)甚至可以有效運行在地理分佈的設備上,這可能通過將多個研究小組和志願者的閒置計算資源結合在一起,有效運行LLM。我們開發了特殊的容錯推理算法和負載平衡協議,自動分配設備以最大化整個系統的吞吐量。我們在 Petals111 的源代碼和文檔中展示了這些算法。

+ 本文提供了有價值的方法,可以在成本效益的情況下運行大型語言模型,對於研究和開發都具有重要意義。

+ 這項研究對於解決推理和微調大型語言模型所面臨的成本和效率問題提供了新的觀點和解決方案。

#大型語言模型 #分散推理 #微調

🌘 GitHub - iamarunbrahma/finetuned-qlora-falcon7b-medical: 使用 QLoRA 在心理健康對話數據集上微調 Falcon-7B LLM

➤ 使用 QLoRA 在心理健康對話數據集上微調 Falcon-7B LLM

✤ https://github.com/iamarunbrahma/finetuned-qlora-falcon7b-medical

本文介紹了使用 QLoRA 在心理健康對話數據集上微調 Falcon-7B LLM 的方法,並提供了相關的數據集和模型。Chatbot 可以作為一種可靠的心理健康支持平臺,但不能替代專業的心理健康護理。微調過的模型可以提供更好的回答,並且可以使用 Gradio 進行演示。

+ 這是一個很有用的工具,可以幫助人們更好地理解心理健康問題。

+ 微調模型需要一定的技術知識,但是這篇文章提供了很好的指導和數據集。

#GitHub #QLoRA #Falcon-7B #心理健康 #對話數據集 #微調

🌖 如何在自定義數據集上微調 GPT 大型語言模型

➤ 介紹 Lit-LLaMA:LLaMA 的最小、優化重寫版本,採用 Apache 2.0 許可證

https://lightning.ai/pages/blog/how-to-finetune-gpt-like-large-language-models-on-a-custom-dataset/

本文介紹如何在自定義數據集上微調大型語言模型,並使用 Lit-Parrot 實現 GPT-NeoX 模型。我們將引導您從安裝到模型下載、數據準備到微調的每一個步驟。

+ 本文提供了詳細的步驟和代碼示例,對於想要在自定義數據集上微調 GPT 模型的研究人員和開發人員非常有用。

+ Lit-Parrot 的推出為 GPT 模型的微調提供了更加簡單、穩定和優化的實現方式,這對於語言模型的應用和發展具有重要意義。

#GPT #自然語言處理 #深度學習 #數據集 #微調

🌕 QLoRA:量化語言模型的高效微調方法

➤ 一種減少內存使用的方法,可在單個48GB GPU上微調650億參數模型,同時保持完整的16位微調任務性能。

https://arxiv.org/abs/2305.14314

本文提出了QLoRA,一種高效的微調方法,通過將梯度反向傳播到凍結的4位量化預訓練語言模型中,進而進行低秩適配器(LoRA)微調,從而減少內存使用,可在單個48GB GPU上微調650億參數模型,同時保持完整的16位微調任務性能。作者們使用QLoRA微調了1000多個模型,提供了對8個指令數據集、多種模型類型(LLaMA、T5)和模型規模的詳細分析,這些分析在常規微調下是不可行的(例如33B和65B參數模型)。研究結果表明,QLoRA微調小型高質量數據集可以實現最先進的結果,即使使用比先前最先進的模型更小的模型也是如此。作者們針對人類和GPT-4評估提供了詳細的聊天機器人性能分析,並發現當前的聊天機器人基準測試不能準確評估聊天機器人的性能水平。

+ 本文提出的QLoRA方法在減少內存使用的同時,保持了完整的16位微

#機器學習 #語言模型 #微調 #量化 #內存使用