Quando il video mente: deepfake, politica e nuove regole

Spoiler: non basta dire “l’ho visto con i miei occhi”. Nel 2025 gli occhi si ingannano benissimo.

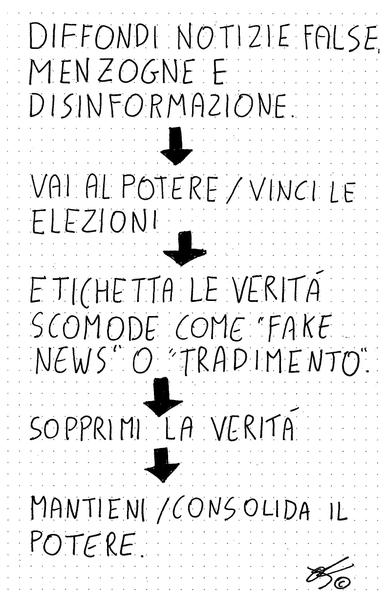

I deepfake non sono più una curiosità da smanettoni: sbucano nelle chat di famiglia, fanno capolino nei telegiornali locali, entrano nei talk show come se nulla fosse. Un volto noto dice cose mai dette, una voce familiare confessa, un video sembra “vero perché lo è”. E invece no. Il punto non è la perfezione tecnica: è la verosimiglianza. Basta che giri abbastanza in fretta da superare la smentita, e il danno è fatto: consenso spostato, reputazioni ammaccate, fiducia erosa. In politica, dove la percezione vale voti, una manipolazione ben piazzata è un megafono.

A tal proposito vi lascio un piccolo e interessante Deep Fake che vi consiglio di visionare attentamente.

https://www.youtube.com/watch?v=6WIlMuy5a_I

Cos’è, davvero, un deepfake? È un contenuto —video, audio, immagine— creato o alterato con intelligenza artificiale per far sembrare reale qualcosa che reale non è. Ne avevo parlato anche in passato qui short.staipa.it/ipuxa, quello che è cambiato è che oggi servono pochi minuti di voce o una manciata di foto per addestrare una copia plausibile. Non occorre l’effetto speciale hollywoodiano: è sufficiente un buon “quasi vero” e un pubblico distratto e polarizzato. Se conferma il nostro pregiudizio, è facile prenderlo per vero senza farci domande. La satira e la parodia esistono da sempre e stanno bene dove stanno, purché non si travestano da informazione. Il confine cambia con il contesto: un meme che dichiara il proprio gioco è un sorriso; un finto comizio spacciato per autentico è manipolazione.

Come si riconosce un deepfake senza diventare tecnici? Si parte dalle orecchie. Gli audio “clonati” hanno spesso micro‑pause bizzarre, risate fuori tempo, consonanti che scivolano: le s che fischiano troppo, le r che sembrano di un’altra regione. Gli occhi a volte battono le ciglia come se il regista avesse dimenticato un fotogramma; le labbra non chiudono bene su p, b, m e i denti hanno quell’aria da “ceramica perfetta” pure quando non dovrebbe. Poi c’è la luce: ombre che non tornano, orecchie e capelli che tremano ai bordi come un green screen impazzito. Infine i segnali sociali: Chi l’ha pubblicato per primo? È un profilo nuovo di zecca? I commenti sono disattivati? Il link è accorciato verso un posto sospetto? Non servono superpoteri: serve tempo. Se un video ci fa arrabbiare o esultare all’istante, la cosa migliore da fare — lo so, è rivoluzionario — è non condividerlo all’istante.

E le regole? Senza trasformare questo pezzo in un esame di diritto, lo spirito è semplice: trasparenza, responsabilità, tutele. La trasparenza chiede di dichiarare quando un contenuto è sintetico o alterato: etichette, watermark, avvisi chiari, soprattutto se si parla di politica o pubblicità. Inciso pratico: negli ultimi mesi i video generati con Sora e rilanciati nel social collegato sono spesso estremamente realistici ma, per fortuna, riportano un watermark: vale la pena cercarlo (e diffidare quando manca, perché potrebbe essere stato ritagliato o coperto nei re‑upload). La responsabilità riguarda chi crea e chi diffonde: se un deepfake causa un danno, se ne risponde, anche civilmente o penalmente; e le piattaforme, quando ricevono segnalazioni circostanziate, non possono far finta di niente. Le tutele servono a chi subisce: rimozione rapida, rettifica, contraddittorio; nei casi gravi (pornografia non consensuale, istigazione all’odio, frode) non è una cortesia, è un dovere.

Cosa sta cambiando nelle regole (UE e Italia), in parole semplici

Non serve un manuale di diritto, bastano tre coordinate. In Italia, dal 10 ottobre 2025, è in vigore la Legge 132/2025 che introduce il nuovo art. 612-quater c.p. sul deepfake non consensuale.

- AI Act (UE): approvato e in applicazione graduale dal 2025. L’idea è chiara: chi genera o pubblica contenuti sintetici deve renderlo evidente (etichette, watermark, avvisi), soprattutto quando il contenuto può incidere su informazione e politica. Per i sistemi che creano video/immagini/audio realistici si richiede anche la documentazione tecnica e misure per evitare abusi.

- DSA – Digital Services Act (UE): impone alle piattaforme meccanismi di segnalazione e rimozione efficaci e valutazioni dei rischi sistemici (manipolazione del discorso pubblico inclusa). In pratica: se segnali bene un deepfake, la piattaforma deve muoversi e dimostrare come limita l’impatto.

- Italia: strumenti già applicabili: non esiste “la legge sul deepfake” come bacchetta magica, ma si applicano norme già in vigore: diffamazione, truffa/frode, diffusione illecita di immagini sessualmente esplicite (art. 612‑ter c.p., vale anche per contenuti sintetici), protezione dati e provvedimenti del Garante Privacy. Tradotto: se c’è un danno, non siamo nel Far West.

Cronaca recente (esempi reali, con fonti)

- 2 luglio 2024 — Giorgia Meloni: udienza a Sassari nel processo contro due imputati per deepfake pornografici a suo danno; richiesta di danni simbolici da destinare a un fondo per le vittime. Fonte: AP News.

- 30 novembre 2024 — Giornalisti SkyTG24 (Mariangela Pira, Lorenzo Borga): volto e voce clonati in video‑truffe d’investimento diffuse sui social. Fonte: SkyTG24.

- 22 maggio 2024 e 22 novembre 2024 — Banca d’Italia: avvisi ufficiali su videomessaggi deepfake che imitano esponenti dell’Istituto per spingere frodi finanziarie. Fonti: Bankitalia 22/05/2024 · Bankitalia 22/11/2024.

- 20 ottobre 2025 — Ilaria Salis: video deepfake politico diffuso sui social e poi rimosso; smentita e ricostruzione dei fact‑checker. Fonte: Facta.news.

“Ma io non uso i social.” Ottimo, ma il deepfake non chiede l’amicizia: arriva lo stesso, inoltrato dallo zio nel gruppo di famiglia, rilanciato dal giornalino locale, raccontato al bar. Qui nasce la tentazione del cinismo: “se è tutto falso, allora vale tutto”. No. È precisamente il momento in cui serve educazione al dubbio: non diventare esperti di forensics, ma imparare a rallentare, a chiedere contesto, a cercare l’origine. È una competenza civica come guardare a destra e a sinistra prima di attraversare.

Cosa possiamo fare, subito, senza strumenti esoterici? Rallentare, appunto. Cercare la fonte: chi l’ha pubblicato, quando, dove; esiste una versione precedente dello stesso video? Controllare un canale ufficiale, un’agenzia, una testata affidabile. Se abbiamo un dubbio sensato, chiediamo aiuto a chi fa fact‑checking: non è un’umiliazione, è manutenzione del dibattito pubblico. E se il contenuto è grave, usiamo gli strumenti di segnalazione, conserviamo prove (URL, screenshot, data e ora) e facciamo i passi necessari con le autorità. Non è per fare i giustizieri della tastiera: è per non fare da amplificatore.

Le tecnologie che generano deepfake non spariranno: miglioreranno. La risposta non è la nostalgia del “si stava meglio quando i video erano sgranati”, ma una cittadinanza digitale capace di guardare una clip e chiedersi: chi me lo sta dicendo, perché adesso, a chi giova? Se una storia è troppo perfetta per essere vera, a volte è perché perfetta lo è, vera un po’ meno. Sta a noi insegnarlo — con pazienza — ogni volta che serve.

#AI #Deepfake #Disinformazione #FactChecking #Privacy