【独自射影構造によるLLM】N4: Nova Nox Neural Network Flash Technical Report

https://qiita.com/peony_snow/items/8ae4e83b8de5c342ab62?utm_campaign=popular_items&utm_medium=feed&utm_source=popular_items

#%E8%87%AA%E7%84%B6%E8%A8%80%E8%AA%9E%E5%87%A6%E7%90%86

ChatGPTでホームページ作成!超簡単に作れた。。。

#チャットgpt #promptengineering #大規模言語モデル #ainews #プロンプト #OpenAIo1mini #openai #howtousechatgpt #オープンai #chatgpt有料版 #GPT4o #chatgpt無料版 #chatgpt使い方 #chatgpt無料 #gpt4 #chatgpt有料 #自然言語処理 #チャットGPTサーチ #言語モデル #ChatGP...

【機械学習】Word2Vecでは見えない「前の単語」──そのときRNNがやってきた。

https://qiita.com/rtkjm22/items/9ac98dbb4e3f5a37c43c?utm_campaign=popular_items&utm_medium=feed&utm_source=popular_items

タメ口が生成AIコストに与える影響 ~「お願いいたします」vs「お願い」~

https://qiita.com/ryu-ki/items/63e022ab807ce20eb522?utm_campaign=popular_items&utm_medium=feed&utm_source=popular_items

TransformerのSelf-Attentionをわかりやすく理解できないものだろうか?-Part1

https://qiita.com/torafukuro/items/7c4ccb0ed445b561eb7c?utm_campaign=popular_items&utm_medium=feed&utm_source=popular_items

LLM技術の革新とその課題

https://gigazine.net/news/20241224-openai-gpt5-orion-delays/ でGPT-5が苦戦中というのが出ているが。

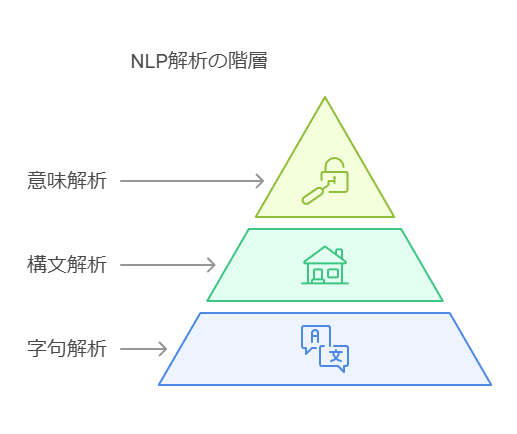

僕の理解では、現状のLLMは古典的な自然言語処理では字句解析、構文解析、意味解析と下から順に階層的に処理して最終的にある問題の回答を求めようとしていたのを、LLMの隠れ層に中間的な工程を委ねていると思っている。古典的な自然言語処理がうまくいかなかったのは階層的な処理だと、例えば字句解析が90%の精度で、構文解析が80%の精度だと仮定すると、構文解析のところで実際の精度は72%になる。そして、工程を経るごとに精度は下がり続け決して上がることはない。

故に実際の問題のところに至るまでに実用的なラインを割り込んでしまう、実際、LLMの登極前の時点で、字句解析、構文解析、意味解析を実用的な精度できちんとやり切っているシステムを私は聞いたことがない。多くの場合は、Eliza的なパターンマッチングなどで動いていたと思う。

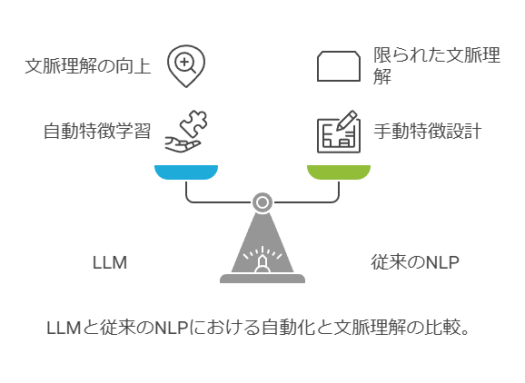

LLMはEnd to endで入力されたものと、出力とを完全に結びつけることで初めて、一つのブレイクスルーを得たと思う。途中を隠れ層に押し込むことで、精度低下を不可視化したと思う。勿論、技術的には活性化関数などや、もちろん計算機の進化によって、深層学習が実用になったこと、そして、Attention機構のようにRNN的な成果を実用的なパフォーマンスで得られるようになったことが大きい。

しかし、根本的には、人間はLLM内で何が起きているかを理解できていないし、結果的にフレーム問題なども前進したかどうかすらわからない。この辺に今のLLMを考える難しさがある。

まるクラ勉強会で「Google Cloudでの自然言語処理のアプローチと所感大全(約2年分)」について話しました #まるクラ勉強会

https://dev.classmethod.jp/articles/approach-and-impressions-of-nlp-on-google-cloud/

#dev_classmethod #まるクラ勉強会 #機械学習 #自然言語処理 #Google_Cloud_Platform

ローカルLLMでAlpacaデータのようなインストラクションデータを自動生成してみた

https://qiita.com/toshi_456/items/2794bdbf6d95e6140db1?utm_campaign=popular_items&utm_medium=feed&utm_source=popular_items

Amazon SageMaker上でText Generation InferenceのMessages APIを使って、オープンなLLMをOpenAI互換なAPIで使ってみた。

https://dev.classmethod.jp/articles/huggingface-tgi-on-amazon-sagemaker/