Встречал заметку с содержанием примерно следующим:

Сайты теряют лишаются трафика из-за #LLM (большие языковые модели), #ИИ и прочих приколюх, которые сканят ресурсы в интернет и в итоге выдают готовый ответ, вместо посещения пользователем страницы ресурса.

Я некоторое время назад начал использовать поисковик #Brave, который является более или менее независимым

спасибо за отличную подборку и сведения характеристик поисковых систем, собранных воедино

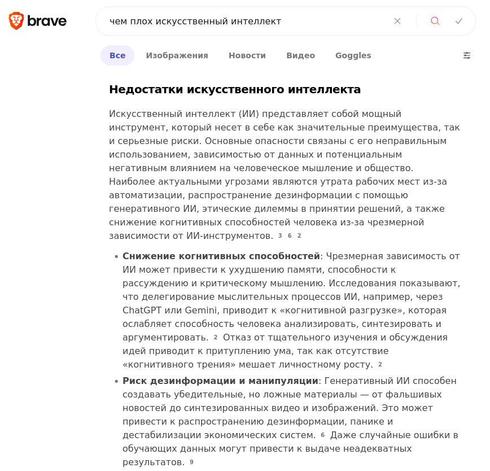

Как классический каталог ссылок он подходит не всегда, тк результаты откровенно хромают, скудные, скомканные, но в поисковой строке есть ИИ, который может объяснить что-то, при этом в тексте содержаться ссылки на источники информации, которые он компилирует в виде готового результата.

И ладно, если бы это просто вело к лени, расхолаживанию и перекладываю своей умственной деятельности по анализу материала на нейросетку, так это ещё избавляет от посещения всяких мутных ресурсов, которые открывать лишний раз совсем не хочется (этакая прокладка как противогаз).

Эти мои бредни никому из авторов не интересны, разумеется, поэтому вряд ли они станут работать над улучшением ресурсов, скорее продолжат и дальше бороться с мельницами, лишний раз их критикуя и обвиняя, потому что это менее затратно, чем работать над улучшением ресурсов

(зато мы хотя бы что-то делаем, ага)

Пример такого поискового запроса на картинках. А в случае, если результаты выдачи не устраивают, можно уже обратится в более классическим и привычным услугам. Текст на картинках содержит ссылки на источники для проверки, если всё-таки это понадобится.

#search #internet #БЯМ #BraveSearch