#MemoryFormation #EmotionalTrauma #LongTermMemory #BrainScience #Psychology #MindBodyConnection #PastExperiences #MemoryScience #NeuroScience #MentalHealth #MemoryFormation #EmotionalTrauma #LongTermMemory #BrainScience #Psychology #MindBodyConnection #PastExperiences #MemoryScience #NeuroScience #MentalHealth https://mastodon.social/@biohackingpathway/116008285537124993

#LongTermMemory

🌀 Giới thiệu **Permem** - bộ nhớ dài hạn tự động cho AI, giúp ghi nhớ thông tin người dùng qua các phiên tương tác:

✅ Tự động trích xuật thông tin quan trọng từ hội thoại

✅ Phân loại & ưu tiên dữ liệu theo ngữ cảnh

✅ Không cần code phức tạp - chỉ 2 dòng lệnh tích hợp

✅ Hỗ trợ quản lý bộ nhớ thủ công nếu cần

AI của bạn sẽ nhớ mọi chi tiết như: sở thích, công việc, phong cách giao tiếp... giúp trải nghiệm "như người thật" hơn!

Thiết kế bộ nhớ dài hạn cho AI: Vượt xa RAG truyền thống. Kết hợp cấu trúc bộ nhớ dạng file dễ đọc, RAG dựa trên embedding và truy xuất bằng LLM để lý luận sâu hơn. Chúng tôi đang tổ chức sự kiện xây dựng mã nguồn mở từ 8/1, dành cho ai quan tâm đến hệ thống bộ nhớ, điều phối tác nhân và ứng dụng thực tế. Tham gia thảo luận tại cộng đồng Discord. #AIMemory #AgentAI #BộNhớAI #TácNhânAI #LongTermMemory

https://www.reddit.com/r/programming/comments/1q4kj54/designing_longterm_memory_for_ai_agents_b

Google Titans architecture, helping AI have long-term memory

https://research.google/blog/titans-miras-helping-ai-have-long-term-memory/

#HackerNews #GoogleTitans #AI #LongTermMemory #AIArchitecture #TechInnovation

Google's "Titans" đạt độ chính xác hồi đáp & suy luận 70% trên 10 triệu tokens trong BABILong, nhờ công nghệ MIRAS giúp AI có bộ nhớ dài hạn. Bước tiến lớn trong lĩnh vực trí tuệ nhân tạo!

#AI #Titans #Google #MIRAS #longtermmemory #trituenhantao #bohoai #congnghe

Google’s new AI agents now juggle consistency, context, short‑term session history, and long‑term memory. The paper dives into context engineering, the Agent2Agent protocol, LLM‑as‑a‑Judge, and observability tricks that keep agents on track. Curious how these advances reshape autonomous AI? Read on for the full breakdown. #GoogleAI #AIAgents #LongTermMemory #ContextEngineering

🔗 https://aidailypost.com/news/google-ai-agents-consistency-context-shortterm-session-history

Tác giả bức xúc vì AI quên chi tiết trong truyện dài. Anh ấy đã tạo JuicyChat, một bot AI có khả năng ghi nhớ thông tin dài hạn. JuicyChat có thể nhớ vết sẹo nhân vật sau hơn 100 tin nhắn và giữ các nhân vật riêng biệt. Nó dùng tóm tắt và ghim chi tiết quan trọng. Mặc dù bản miễn phí giới hạn, nhưng bộ nhớ là điểm nổi bật. Bạn có từng gặp vấn đề này không?

#AI #Chatbot #JuicyChat #LongTermMemory #Innovation

#TríTuệNhânTạo #BotAI #GhiNhớDàiHạn #SángTạo

#MemoryFormation #EmotionalTrauma #LongTermMemory #BrainScience #Psychology #MindBodyConnection #PastExperiences #MemoryScience #NeuroScience #MentalHealth #MemoryFormation #EmotionalTrauma #LongTermMemory #BrainScience #Psychology #MindBodyConnection #PastExperiences #MemoryScience #NeuroScience #MentalHealth https://mastodon.social/@biohackingpathway/115296537648047131

Orb2, the fly homolog of CPEB, forms #prion-like oligomers involved in maintenance of #LongTermMemory. This study identifies #Hsp40 family chaperone Mrj as a regulator of #Orb2 oligomerization and its association with translating ribosomes #PLOSBiology https://plos.io/4aRba2j

Who knew bite-sized learning could be so filling? 😉

https://learnlever.com/maximize-learning-potential-with-microlearning/

In forming long-term memories, vascular cells are crucial

https://www.sciencedaily.com/releases/2023/10/231002124239.htm

Neuronal activity drives IGF2 expression from pericytes to form long-term memory

https://www.cell.com/neuron/fulltext/S0896-6273(23)00664-5

#LTM #memory #IGF# #MolecularBiology #LongTermMemory #neuroscience

[thread] LLM, memorization, long-term memory, forgetting

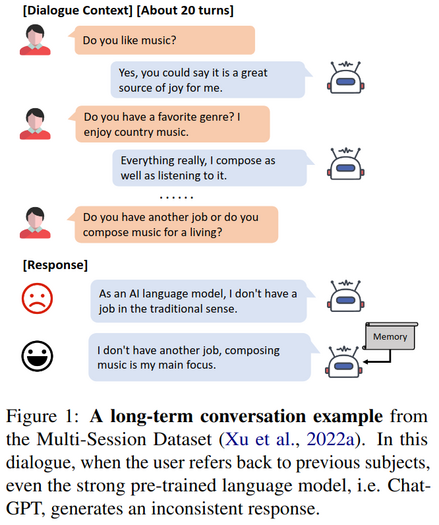

Recursively Summarizing Enables Long-Term Dialogue Memory in Large Language Models

https://arxiv.org/abs/2308.15022

Discussion: https://news.ycombinator.com/item?id=37363362

* recursively gen. summaries to enhance long-term memory

* LLM memorize small dialogue contexts

* then recursively produce new memories using previous memory + following contexts

* LLM can then generate highly consistent response w. help of latest memory

Very excited that my first paper with Alessandra Souza and Klaus Oberauer is now published in @PNASNews

We investigated the mechanisms underlying repetition learning as a model system for the interaction between #workingMemory and #longTermMemory. By using a Bayesian hierarchical mixture modeling approach to model learning curves on the individual level, we reveal misconceptions in current theories which resulted from aggregating data over individuals.

"I suffer from #TestAnxiety" is more likely to mean "I mistook my #WorkingMemory for my #LongTermMemory"

How #sleep shapes what we remember—and what we forget. Researchers are starting to decode the #neural changes during sleep that underlie #LongtermMemory. A PNAS news feature: https://www.pnas.org/doi/10.1073/pnas.2220275120 #neuron #synapse #hippocampus #brain