Automatisierte Rasterfahndung: Tür zu für Palantir und Co.

Dieser Artikel stammt von Netzpolitik.org.

Automatisierte Rasterfahndung: Tür zu für Palantir und Co.

Die angehende Regierung befürwortet Polizeiarbeit mit automatisierten Black-Box-Systemen, um die riesigen Datenbestände der Polizeien zu rastern. Die Idee der Merzschen Union, die auch von den Sozialdemokraten unterstützt wird, mit Konzernen wie Palantir zusammenzuarbeiten, ist ethisch und rechtlich hochproblematisch.

07.04.2025 um 17:29 Uhr

– Constanze, Stefan Ullrich – in Überwachung – keine Ergänzungen Palantir sammelte 2020 an der New Yorker Börse Milliarden ein. – Alle Rechte vorbehalten Real Fiction Filmverleih

Als vor ein paar Tagen erste Papiere den Verhandlungsstand der Arbeitsgruppen der angehenden Regierungskoalitionäre in der Innenpolitik aufzeigten, gab es wenige Überraschungen. Vieles erinnerte deutlich an die Lektüre der Wahlprogramme. Derzeit brütet eine 19-köpfige Verhandlungsgruppe aus CDU, CSU und SPD über den Ergebnissen der Arbeitsgruppen.

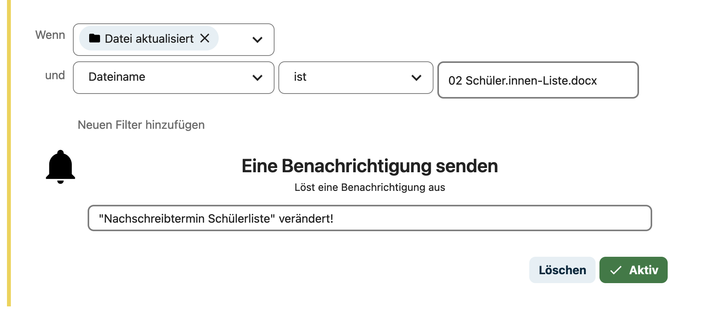

Ein Ergebnis war das Ziel, in Zukunft massenhaft vorhandene Polizeidaten zusammenzuführen und automatisiert auszuwerten: „Für bestimmte Zwecke sollen unsere Sicherheitsbehörden, unter Berücksichtigung verfassungsrechtlicher Vorgaben und digitaler Souveränität, die automatisierte Datenrecherche und -analyse […] vornehmen können.“ Bisher ist das nur in drei Bundesländern gängige Praxis und wird derzeit mit mehreren Verfassungsbeschwerden bekämpft.

Die Merzsche Union setzt sich schon länger offensiv für ein Produkt des Konzerns Palantir ein. Das börsennotierte militärnahe US-Tech-Unternehmen bietet eine proprietäre Software namens „Gotham“ an, die auf Beamtendeutsch „Bundes-VeRA“ heißt. Schon im Wahlprogramm hatte die Union versprochen, dass die Bundespolizei und das Bundeskriminalamt alsbald mit diesem Produkt ertüchtigt werden sollen.

Das Verhandlungspapier spricht nun von „Sicherheitsbehörden“, was eine Erweiterung zum bisher Geforderten darstellt. Denn neben Polizeien könnte das auch Geheimdienste umfassen, die im quasi rechtsfreien Raum schon mindestens seit 2014 mit solchen Werkzeugen arbeiten.

Palantir

Wir berichten mehr über Palantir als uns lieb wäre. Unterstütze unsere Arbeit!

Die Sozialdemokraten schrieben in ihr Wahlprogramm den Wunsch, der Bundespolizei „automatisierte (KI-basierte) Datenanalysen“ zu erlauben. Innenministerin und Sozialdemokratin Nancy Faeser hatte sich allerdings in ihrer Ampel-Amtszeit gegen die Nutzung von Palantir in Bundesbehörden ausgesprochen.

Etwas wahrhaft Magisches

Offenbar nehmen die Demnächst-Koalitionäre an, dass solche Software-Produkte für die Polizei einen hohen Nutzen haben. Das ist zwar bisher nicht wissenschaftlich belegt, aber das Marketing von Anbietern wie Palantir bei den Verantwortlichen in Politik und Polizei blieb wohl nicht ohne Wirkung. Früher beschrieb man es mit dem jetzt als unmodern geltenden Begriff „Data Mining“. Heute soll eine nicht näher spezifizierte „KI“ die Informationen aus lauter heterogenen polizeilichen Datenbanken zusammenbringen und dann diejenigen Menschen auf Knopfdruck herausfischen, die potentiell eine Gefahr darstellen.

Der Moment, einen solchen Produkteinsatz kräftig auszubauen, ist günstig: Alles, was auch nur im Entferntesten nach Künstlicher Intelligenz aussieht, wird gerade mit Innovation und Effizienzsteigerung gleichgesetzt. Es ist eine Variante des alten Versprechens von Big Tech, ungeachtet von Datenschutz- und Antidiskriminierungsgesetzen wahrhaft Magisches mit Hilfe von Daten zu vollbringen.

Verbunddateien, Datenbanken, Auskunftssysteme

Die teilweise schon Jahrzehnte bestehenden Datenbanken der Polizeien haben im Laufe ihrer Dienstjahre eine Vielzahl an unterschiedlichsten Daten angehäuft. Es gibt Verbunddateien, die der Personen- und Sachfahndung dienen, mit Kriminalakten und Haftinformationen, dazu Biometriedaten wie Fingerabdrücke, Gesichtsbilder oder gar DNA-Profile. Es gibt aber auch Fallbearbeitungssysteme oder auch erkennungsdienstliche Datenbanken, ebenfalls mit biometrischen Informationen. Nicht zu vergessen die großen Antiterror- und die Rechtsextremismusdateien, die seit vielen Jahren geführt werden. Dazu kommen noch Auskunfts- und Informationssysteme, die Fahndungen und Ermittlungen unterstützen sollen, außerdem riesige Vorgangsbearbeitungssysteme, die mit Daten aus dem polizeilichen Alltag wie Anzeigen oder Verkehrsunfällen befüllt sind.

Ein einziger Datenschatz, der gehoben werden muss, wenn es nach den Anbietern entsprechender Software wie Palantir und nach den Konservativen mit ihrem latenten Law-and-Order-Fetisch geht. Mit „KI“-Hilfe sollen neue Muster in großen Datensätzen gesucht werden: Informationsnuggets werden regelrecht „geschürft“. Dazu müssen vorliegende Daten automatisiert klassifiziert werden, auch hinsichtlich ihrer Verbindungen untereinander.

Ein unmittelbarer Nutzen für die Polizei scheint klar: Auch unbekannte Muster werden in bekannte Klassen überführt. Ein zweiter praktischer Nebeneffekt der Nutzung des nun in KI umgetauften Data Minings ist die Erkennung von „Ausreißern“. Das ist der Fachbegriff für Datenpunkte, die stark vom restlichen Vergleichsdatensatz abweichen. Je nach Einsatzzweck des IT-Systems können diese Ausreißer automatisch ignoriert werden, um beispielsweise schönere Info-Graphiken zu bekommen, oder aber – ganz im Gegenteil – genauer unter die Lupe genommen werden.

Ein in der Informatik lange bekanntes Problem von Data Mining ist die Sicherstellung des rechtskonformen Betriebs einer solchen Raster-Suchmaschine. Denn auch wenn personenbezogene Daten in einem System nicht direkt vorhanden sind oder aufwendig anonymisiert wurden, kann ein entsprechendes Data-Mining-System solche privaten Daten ableiten – gewollt oder ungewollt.

Informatikfachleute, die solche Systeme entwerfen, herstellen, betreiben oder verwenden, müssen daher große Sorgfalt an den Tag legen, um Datenschutzrechte einhalten zu können. Diese Sorgfalt ist teuer und führt im Extremfall sogar dazu, dass ein solches System rechtlich oder ethisch abzulehnen ist. Doch im Falle von Palantir steht alles auf dem Kopf: Aus den Polizeisystemen sollen ja gerade nicht direkt vorhandene Daten abgeleitet werden, um einen Personenbezug herzustellen. Entsprechend umfassend sind die ethischen Fragen, die im Raum stehen.

Der feisten Datenrallye stehen nicht nur ethische Bedenken, sondern auch ein Urteil des höchsten deutschen Gerichts im Weg. Das Bundesverfassungsgericht beschäftigte sich mit zwei Landesgesetzen, die den Polizeien das Palantir-Produkt genehmigt hatten. Die betroffenen Paragraphen des hessischen Sicherheits- und Ordnungsgesetzes und des hamburgischen Gesetzes über die Datenverarbeitung der Polizei wurden 2023 als verfassungswidrig befunden. Das Gericht kritisierte die enorm hohe Streubreite und Intensität der Grundrechtseingriffe.

Profiling- und Diskriminierungsvorsorge

Seit den Zeiten von „Big Data“ suggeriert die These „Daten sind das neue Öl“, dass wir es mit einer ungenutzten sprudelnden Quelle zu tun hätten. Warum beschränken höchstrichterliche Urteile – vom Volkszählungsurteil bis zum jüngsten Palantir-Urteil – die Polizei darin, diesen Datenschatz zu heben? Der Grund erschließt sich leicht an typischen Beispielen: In Polizeidatenbanken dürfen zum Beispiel auch Merkmale über Menschen gespeichert werden, die eine „Volkszugehörigkeit“ oder einen „Phänotyp“, die „äußere Erscheinung“ oder Religionszugehörigkeit, verwendete Sprachen, Dialekte oder Mundarten festhalten. Das sind ohne Zweifel höchst sensible Daten, auch mit hohem Diskriminierungspotential.

Denn Datenschutz bedeutet auch Diskriminierungsvorsorge und beschränkt die Profilbildung über Menschen. Die europäische Datenschutzgrundverordnung und die begleitende Richtlinie zum Datenschutz für Justiz und Inneres sind in dieser Hinsicht eigentlich klar formuliert:

Profiling, das zur Folge hat, dass natürliche Personen auf Grundlage von besonderen Datenkategorien nach Artikel 10 [der Richtlinie] diskriminiert werden, ist nach dem Unionsrecht verboten.

Und das Profiling würde im konkreten Falle einer Palantir-Rasterfahndung nicht nur Beschuldigte betreffen, sondern auch eine Vielzahl anderer Personen. Das sind etwa Geschädigte oder Zeugen, sofern ihre Daten in den behördlichen Datenbanken gespeichert und verarbeitet werden.

Auch deswegen gilt der Grundsatz der Zweckbindung. Das bedeutet in einfachen Worten, dass Daten für einen bestimmten Zweck erhoben wurden und nicht einfach ins Blaue hinein umfunktioniert werden können. Also dürfen Personendaten aus Polizeidatenbanken nur dann für einen anderen Zweck verwendet werden, wenn dieser neue Zweck dem Schutz eines mindestens ebenso bedeutenden Rechtsguts dient wie der ursprüngliche Erhebungszweck.

Es bleibt aber eine Tür offen für Palantir und Co.: Denn für präventive Polizeiarbeit, die schwere Straftaten verhindern soll, ist diese Zweckbindung gelockert. Es ist allerdings verfassungsrechtlich umstritten, ob auch automatisierte Datenanalysen die Zweckbindung entkernen können. Immerhin gelten seit dem Palantir-Urteil vom Februar 2023 neue verfassungsrechtliche Anforderungen, die sowohl quantitative als auch qualitative Grenzen setzen, was die Art der Daten betrifft, die von der Software automatisiert ausgewertet werden darf. Es ist demnach nicht verfassungsgemäß, wenn die Polizei „mit einem Klick umfassende Profile von Personen, Gruppen und Milieus“ erstellt.

Bestehende Datenschutzrechte werden ad absurdum geführt

Palantir arbeitet schon heute mit den Polizeien in Hessen, Hamburg und Nordrhein-Westfalen eng zusammen. In welchem Ausmaß und mit welchen Palantir-Softwarefunktionen und wie genau dabei auch höchst sensible Informationen über Menschen verarbeitet werden, ist öffentlich nicht einsehbar und strukturell geheim. Wie die namensgebenden Palantíri in Tokiens „Der Herr der Ringe“ bleiben die Softwaresysteme des Konzerns in geheimen Räumen, nur konzerneigene Hüter haben echten Zugang. Der Konzern Palantir entzieht sich der öffentlichen Diskussion weitgehend und damit der Rechenschaft.

Diese Intransparenz der Polizeiarbeit mit Black-Box-Systemen macht Datenschutzverletzungen quasi über Bande unkenntlich und unkontrollierbar. Es führt zugleich bestehende Datenschutzrechte ad absurdum, die jeder Mensch eigentlich hat: beispielsweise das Recht zu erfahren, welche Daten über einen selbst vorliegen oder deren Löschung oder Berichtigung zu verlangen. Diese Rechte angemessen zu wahren, wird kaum machbar sein. Informationen über Menschen liegen ja dann nicht mehr nur in herkömmlicher Form vor, etwa in einer Datenbank, sondern werden auch innerhalb des „KI“-Systems gespeichert und verarbeitet. Ob und wie Konzerne wie Palantir personenbezogene Informationen in ihren „KI“-Systemen korrigieren oder löschen können, ist eine offene Frage.

Im konkreten Fall von Palantir verbinden sich mit dem Konzern auch noch problematische Motive und nationalistische Ideologien, die von den beiden prominenten Männern der Chefetage des Konzerns offen vertreten werden: Peter Thiel und Alexander Karp. Ausgerechnet diesem Konzern mit seiner undurchsichtigen Überwachungssoftware massenhaft Polizeidaten anzuvertrauen, scheint eine wirklich schlechte Idee.

Es ist daher nicht länger die Frage, ob die Systeme von Palantir und Co. ethisch und rechtlich problematisch sind und gesellschaftsfeindlich und demokratiezerstörend eingesetzt werden könnten, sondern wie dies verhindert werden kann.

Zur Quelle wechseln

Zur CC-Lizenz für diesen Artikel

Author: Constanze