On route to #redhatsummit, watch out for: "AI inferencing for developers and administrators", "Securing AI workloads with RamaLama", "RamaLama Making developing AI Boring". We may even see a vlm demo, very accurate models as we can see here #ramalama #llamacpp

#LlamaCpp

@ru @ru_ng

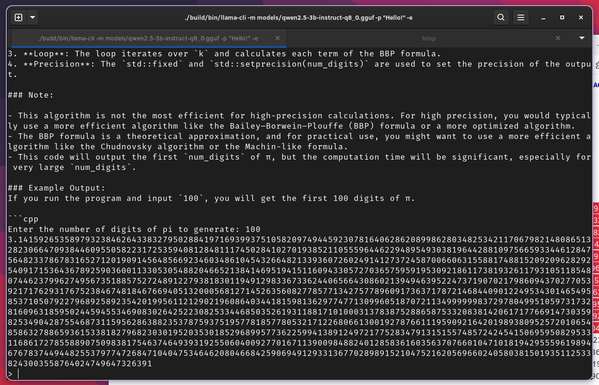

Кто мне может объяснить: почему на моём старом компе модель Vikhr-Llama-3.2-1B-Q8_0.gguf (1,2ГБ), запущенная через llama.cpp, выдаёт:

prompt eval = 1,72 token/second

eval = 0,97 token/second

а Vikhr-Qwen-2.5-1.5b-Instruct-Q5_K_M.gguf (1,0ГБ) вычисляется медленнее и выдаёт:

prompt eval = 0,26 token/second

eval = 0,17 token/second

? (конец вопроса)

Vikhr-Qwen же поменьше размером и квантизирована сильнее. Вычислений должна же требовать меньше и генерировать ответ быстрее, как я понимаю.

Мой компьютер: Pentium D E6300 на 2,8Ггц (максимум SSSE3), оперативная память DDR2 на 4ГБ и SSD на 64ГБ подключен через SATA2.

Спасибо.

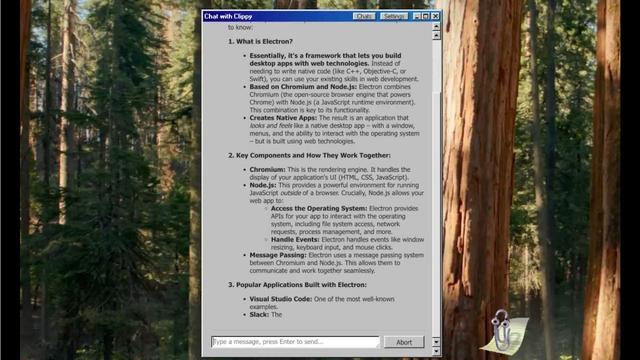

Microsoft Clippy Returns as AI Assistant, Empowered By LLMs You Can Run Locally on Your PC

#AI #Clippy #AIClippy #AIAssistants #LLMs #LocalAI #OpenSource #ElectronJS #LlamaCpp #GGUF #Gemma3 #Llama3 #Phi4 #Qwen3 #RetroTech #MicrosoftOffice #OnDeviceAI

А llama.cpp достаточно легко и просто скомпилировалась в моей 32битной altlinux. Зависимостей мизер. Ничего не потребовалось доустанавливать, компилить. При этом работает стабильно, не ругается, не сегфолтиться.

Тестил с Vikhr-Llama-3.2-1B-Q8_0.gguf, которая на 1,2ГБ и знает русский язык. Скорость "чтения" промпта 2 токена/сек. А скорость генерации ответа 1 токен/сек. Для вопросов "не к спеху" можно использовать, но качество ответа так себе.

Замечу, что компьютер у меня старенький: Pentium D E6300 на 2,8Ггц, поддерживает максимум SSSE3 и работает с памятью DDR2 на 4ГБ. По этому, то, что есть уже радует меня)

Big hopes for Qwen3. IF the 30A3B model works well, gptel-org-tools will be very close to what I envision as a good foundation for the package.

It's surprisingly accurate, especially with reasoning enabled.

At the same time, I'm finding that #gptel struggles a lot with handling LLM output that contains reasoning, content and tool calls at once.

I'm stumped. These new models are about as good as it's ever been for local inference, and they work great in both the llama-server and LM Studio UI's.

Changing the way I prompt doesn't work. I tried taking an axe to gptel-openai.el, but I frankly don't understand the code nearly well enough to get a working version going.

So... yeah. Kinda stuck.

Not sure what next. Having seen Qwen3, I'm not particularly happy to go back to older models.

#emacs #gptelorgtools #llamacpp

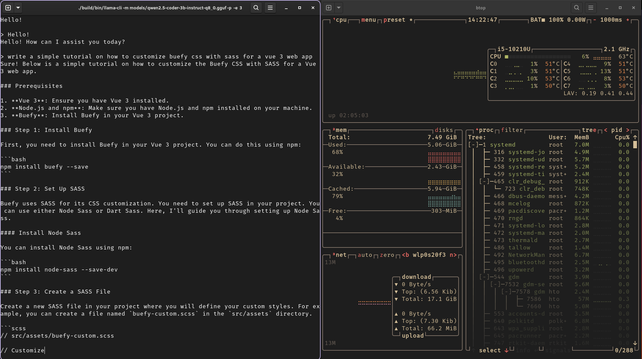

Run AI completely offline with Llama-CLI and C#! 🚀

No cloud. Full control.

Watch the full guide here: https://www.youtube.com/watch?v=lc6lVCe0XHI

#AI #CSharp #OfflineAI #LlamaCpp

Как запустить локально LLM, если ее веса не помещаются в [видео]память

Некоторые люди предпочитают пользоваться не только облачными сервисами, но и запускать LLM у себя дома. Например, так можно запустить дообученные модели без цензуры, или не посылать в облако свои личные документы. А то и запускать бесчеловечные эксперименты над LLM так, чтобы superintelligence/skynet потом это не припомнил. Есть много моделей, оптимизированых для быстрой работы на устройствах с небольшой памятью. Но к сожалению, веса самых продвинутых моделей, которые играют в одной лиге с лучшими онлайн моделями, занимают сотни гигабайт. Например, 8-битные веса Deepseek R1-671B занимают 700 гигабайт, квантованые q4 — 350 гигов. Можно квантовать и в 1 бит, размер тогда будет около 90 гигов, но такая модель почти бесполезна. Еще есть много качественных finetunes на основе Mistral-Large-instruct-130B, Qwen2.5-72B, llama3.3-70B, веса которых также не помещаются в память старших моделей видеокарт.

Started preparing for my next talk on @u3acommunities.org.

Will outline running #generativeai locally, mainly for privacy reasons.

Will include #llamacpp #ollama #AUTOMATIC1111 #openwebui and probably others.

Any pointers of things to mention appreciated !

🐪🤯 Oh, the riveting saga of Llama.cpp's heap—it’s like watching paint dry, but with more compiler errors. Our intrepid hacker spent 30 hours (yes, you read that right) dissecting code so niche, even the bugs were disinterested. 🐛💤

https://retr0.blog/blog/llama-rpc-rce #LlamaCpp #Debugging #CodeNiche #CompilerErrors #HackerNews #HackerNews #ngated

Heap-overflowing Llama.cpp to RCE

https://retr0.blog/blog/llama-rpc-rce

#HackerNews #HeapOverflow #LlamaCpp #RCE #CyberSecurity #Exploit #TechNews

I've just published the second part of my guide on setting up an AI/LLM stack in Haiku. If you've been curious about running AI models on alternative operating systems, this one's for you!

🔗 https://blog.nexus6.me/new%20adventures%20in%20ai/Setup-an-environment-for-AI-in-Haiku-Part-2/

#HaikuOS #langchain #openai #llamacpp

I've just published the first part of my guide on setting up an AI/LLM stack in Haiku. If you've been curious about running AI models on alternative operating systems, this one's for you!

🔗 https://blog.nexus6.me/new%20adventures%20in%20ai/Setup-an-environment-for-AI-in-Haiku-Part-1/

#HaikuOS #langchain #openai #llamacpp

Llama.cpp AI Performance with the GeForce RTX 5090 Review — https://www.phoronix.com/review/nvidia-rtx5090-llama-cpp

#HackerNews #LlamaCPP #AI #GeForceRTX5090 #NVIDIA #Review #TechNews

It seems like metal-enabled #llamacpp using #gguf is faster than llama.cpp with #mlx on my #AppleSilicon. #Ollama is mlx-only and slower, so not just a tool optimization.

MLX was designed for Metal so should be faster. Maybe it helps more with Apple Intelligence or something? I now choose GGUF over MLX unless I specifically need Ollama.

Anyone else had similar experiences? Do newer M-series chips do a better job with it, or did I not account for something?

llama.cpp now supports tool calling (OpenAI-compatible)

https://github.com/ggerganov/llama.cpp/pull/9639

On top of generic support for *all* models, it supports 8+ models’ native formats:

- Llama 3.x

- Functionary 3

- Hermes 2/3

- Qwen 2.5

- Mistral Nemo

- Firefunction 3

- DeepSeek R1

Runs anywhere (incl. Raspberry Pi 5).

On a Mac:

brew install llama.cpp

llama-server --jinja -fa -hf bartowski/Qwen2.5-7B-Instruct-GGUF:Q4_K_M

Still fresh / lots of bugs to discover: feedback welcome!

Running the full DeepSeek-R1 (671B parameters) is challenging. Unsloth has now provided a quantized version (DeepSeek R1

Dynamic 1.58-bit), reducing the memory from 720GB to 131 GB:

https://unsloth.ai/blog/deepseekr1-dynamic

I can confirm that it works with a 24 GB GPU and 128 GB (normal) RAM. Not fast, of course, but still possible. The results so far are looking promising.

For more details, I would recommend to read their blog post.

官方版 (?) 的 llama.vim

Hacker News 上看到「Llama.vim – Local LLM-assisted text completion (github.com/ggml-org)」這篇,算是官方版本的 llama.cpp + Vim 整合方案,可以想像就是本機跑的 GitHub Copilot。

雖然去年十月專案就起跑了,但目前看起來還是屬於開發前期?文件還沒有很齊全,遇到問題看 source code 會比較快。

官方提到能跑的 model 目前主要就是 Qwen2.5-Coder,授權上是 Apache

https://blog.gslin.org/archives/2025/01/25/12234/%e5%ae%98%e6%96%b9%e7%89%88-%e7%9a%84-llama-vim/

#Computer #Murmuring #Programming #Software #copilot #llama #llamacpp #llamavim #llm #programming #vim

🚀 Meet llama-run, the newest tool in the llama.cpp ecosystem! Simplify running LLMs with one command, flexible configs, and seamless integration into OCI environments. Focus on outcomes, not infrastructure.

https://developers.redhat.com/blog/2024/12/17/simplifying-ai-ramalama-and-llama-run

Мне кажется или CLI llama.cpp разучился вытирать реверс-промпт из ChatML-ответов?

$ llama-cli -m ./models/openhermes-2.5-neural-chat-7b-v3-1-7b/ggml-model-q5_k_m.gguf -n -1 -t 4 --color -f prompts/chat-with-chatml.txt --prompt-cache ./models/openhermes-2.5-neural-chat-7b-v3-1-7b/ggml-model-q5_k_m_chat-with-chatml.txt.prompt --ctx-size 2048 -cnv --in-prefix '<|im_start|>user\n' --in-suffix '<|im_end|>\n<|im_start|>assistant\n' --reverse-prompt '<|im_end|>' --chat-template chatml

...

== Running in interactive mode. ==

— Press Ctrl+C to interject at any time.

— Press Return to return control to the AI.

— To return control without starting a new line, end your input with '/'.

— If you want to submit another line, end your input with '\'.

<|im_start|>system

You are a helpful assistant<|im_end|>

<|im_start|>user

Hello<|im_end|>

<|im_start|>assistant

Hi there<|im_end|>

<|im_start|>user

Who are you<|im_end|>

<|im_start|>assistant

I am an assistant<|im_end|>

Howdy?Hello again<|im_end|>

Вот чего он этот "<|im_end|>" мне показывает?! #llm #? #llama.cpp