Jamie Curnow released #Nginx Proxy Manager version 2.12.5. https://nginxproxymanager.com/

#Nginx

También redacté algo sobre los logs. No es mucho, pero ya vendrán más datas sobre eso, interesante. https://elprofejuan.duckdns.org/revisando-el-servidor #servidorCasero #logs #fail2ban #nginx

Mal eine klare Empfehlung für #SearXNG

Das läuft seit einen Monat ohne Probleme bei mir.

Die Suchmöglichkeiten und Ergebnisse finde deutlich besser als bei #DuckDuckGo

Was auch ziemlich cool ist ist die Netzwerkfähigkeit mit #nginx und #Tor Hidden Service.

Für Firefox gibt es ein passendes addon Namens #SearXNG4all

Da kann man dann die passende Adresse eingeben.

Leider findet #Torbrowser für Android das addon nicht und ich musste mir da ein Lesezeichen setzen.

https://github.com/searxng/searxng

when building #nginx from source, does anyone know how to get it to link against a pre-existing openssl in /usr/fractal/lib/64 with libraries in /usr/fractal/include? the options in the help for ./configure only talk about building openssl *with* nginx, which is not what we want

Wow ok, done

That was so easy

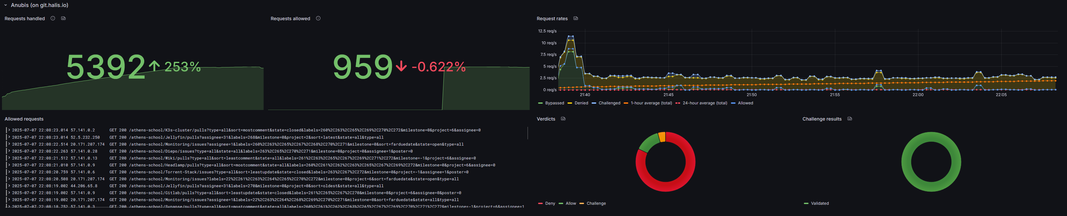

Kudos to this blog post for the amazing tutorial : https://xeiaso.net/blog/2025/anubis/

Managed to also quickly add a grafana dashboard to reflect some metrics, and those numbers give some perspective to the insane spam all the internet is under, just to generate more slop

#selfhosted #homelab #kubernetes #grafana #prometheus #anubis #gitea #faang #spam #ai #nginx #ingress #scraping

Ok, time to deploy Anubis in front of Gitea, I'm done with those FAANG oligarchs scraping my repos 24/7 to check if anything changed...

F*ck off.

But that also means Gitea might get unstable for some time, woops

If you are curious : https://git.halis.io

If you see the cute furry, it worked

#homelab #selfhosted #kubernetes #anubis #nginx #ingress #gitea #ai #scraping #faang

Handy little SSL config generator this; https://ssl-config.mozilla.org/

#homelab #hosting #config #configuration #ssl #nginx #server

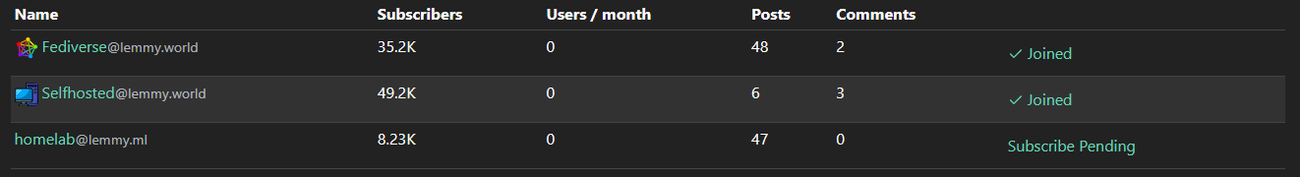

Today is finishing with a great win !

I finally got my lemmy instance to federate properly with other instances and communities

It took me multiple months of sporadic testing to understand the way everything (especially the ingress) talks around

Now, lemmy.halis.io is running photon and is up and running, just waiting to be populated

Feel free to come and say hi :)

#homelab #selfhosted #ingress #kubernetes #nginx #fediverse #lemmy #photon

Как мы подняли современный портал документации из россыпи .md файлов: пошаговое руководство по MkDocs + Material

От хаоса в Markdown-файлах до стильного, быстрого сайта с поиском, темами и мультиязычностью за один вечер. В жизни почти каждого IT-проекта наступает момент, когда количество файлов README.md , GUIDE.md , docs.txt и заметок в Confluence достигает критической массы. Документация становится фрагментированной, поиск нужной информации превращается в квест, а новые члены команды тратят часы на то, чтобы просто понять, "что где лежит".

https://habr.com/ru/articles/925306/

#mkdocs #python #nginx #devops #tutorial #selfhosted #linux #faq

12 Tage war #FreshRSS krank. Nun läuft es wieder, Gott sei Dank.

✅ #Restore mit #restic

✅ Havarierte InnoDB repariert und Datenbestand gerettet

✅ Containerlandschaft mit #nginx ProxyManager und aktueller #MariaDB via #Podman lokal

✅ Deployment auf 24x7 Server mit #RAID6

Nun fehlt noch das Upgrade von 1.19 auf die aktuelle Release. Habe das lange sträflich schludern lassen, aber in der aktuellen Containerlandschaft ist es auch leichter, alles sauber zu halten.

Jetzt hab' ich einen #RaspberryPi 1 über...

Расследование: Почему Let's Encrypt не видит TXT-запись? Детективная история с wildcard-сертификатами на DNS Selectel

Привет, Хабр! Я разработчик сервиса Leopult.ru — платформы для создания сайтов муниципальных учреждений. Уже 11 лет мы помогаем десяткам тысяч клиентов в России запускать и поддерживать их веб-ресурсы. Сегодня я расскажу о своем расследовании загадочной ошибки при выпуске wildcard-сертификатов через Let's Encrypt. Если вы сталкивались с acme: error: 403 :: urn:ietf:params:acme:error:unauthorized :: No TXT record found , то эта история для вас. Погрузимся в мир DNS, API и, возможно, теней РКН, чтобы понять, почему сертификаты перестали выдаваться, и как я это починил. Спойлер: виноваты не только DNS-серверы!

🚫 Oh, the riveting tale of "403 Forbidden"! Apparently, PCIe 5.0's greatest impact is turning GPU creators into digital outcasts while #LLMs sit in a corner weeping. 🤖📴 Thanks, #nginx, for blocking our access to enlightenment.

https://www.pugetsystems.com/labs/articles/impact-of-pcie-5-0-bandwidth-on-gpu-content-creation-performance/ #403Forbidden #PCIe5 #DigitalOutcasts #HackerNews #ngated

#ArchiveBox のWeb UIもAPIもブラウザプラグインも使いづらすぎたので、Web UIを無理やり操作してどうにかするWebページを作成した

フロントに置いてる #nginx の設定でまぜまぜして同じドメイン傘下のpath違いということにして、iframe内のArchiveBoxをDOMでごにょごにょしつつ、操作時はPOSTをエミュレーションする力業

これでだいぶ便利になったぞー

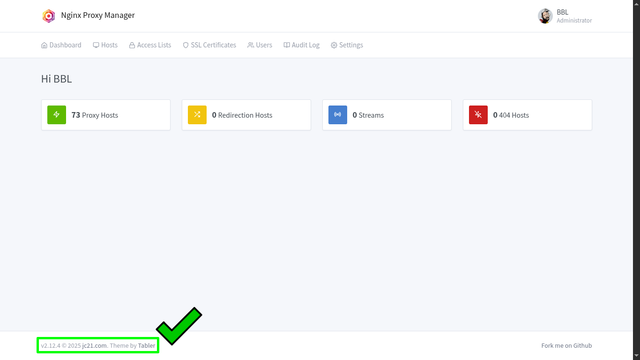

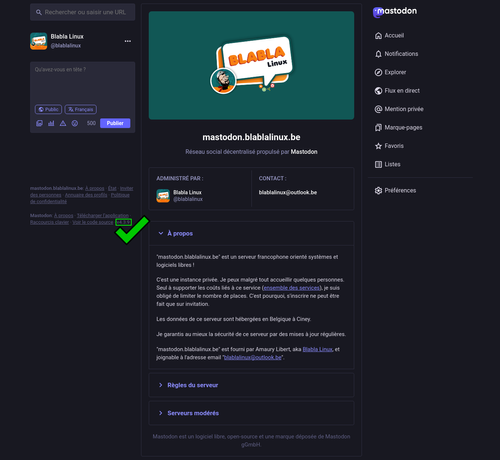

Mises à niveaux services de la soirée…

#Nginx Proxy Manager passe en version 2.12.4 ✔️

👉 Site officiel : https://nginxproxymanager.com

#Mastodon passe en version 4.3.9 ✔️

👉 Site officiel : https://joinmastodon.org/fr

👉 Chez Blabla Linux : https://mastodon.blablalinux.be

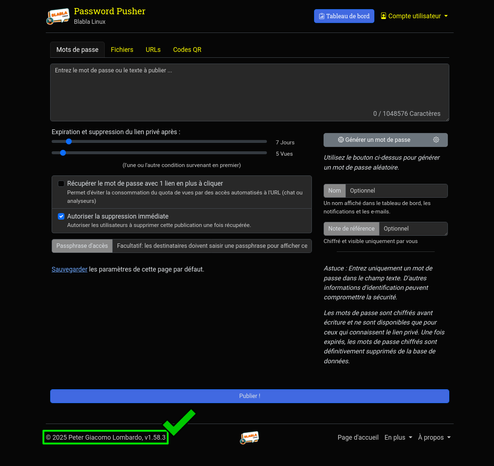

#PwPush (Password Pusher) passe en version 1.58.3 ✔️

👉 Site officiel : https://docs.pwpush.com

👉 Chez Blabla Linux : https://pwpush.blablalinux.be

How to Setup a Reverse #Proxy with HTTPS Using #Nginx and #Certbot (5 Minute Quick-Start Guide)

This article outlines how to setup a reverse proxy with HTTPS using Nginx and Certbot.

What is a Reverse Proxy?

A reverse proxy is a server that sits between client devices and a backend server, forwarding client requests to the backend server and returning the server's response to the clients. Unlike a forward proxy, ...

Continued 👉 https://blog.radwebhosting.com/how-to-setup-a-reverse-proxy-with-https-using-nginx-and-certbot-5-minute-quick-start-guide/?utm_source=mastodon&utm_medium=social&utm_campaign=mastodon.raddemo.host #reverseproxy #proxyserver #letsencrypt

https://exception.net.ua/post/how-to-setup-your-own-xmpp-server/

#Україна #уанет #Ukraine #uanet #ExceptionNetUa #turnserver #selfhost #prosody #jabber #coturn #nginx #linux #xmpp

How to Setup a Reverse #Proxy with HTTPS Using #Nginx and #Certbot (5 Minute Quick-Start Guide)

This article outlines how to setup a reverse proxy with HTTPS using Nginx and Certbot.

What is a Reverse Proxy?

A reverse proxy is a server that sits between client devices and a backend server, forwarding client requests to the backend server and returning the server's response to the clients. Unlike a forward proxy, ...

Continued 👉 https://blog.radwebhosting.com/how-to-setup-a-reverse-proxy-with-https-using-nginx-and-certbot-5-minute-quick-start-guide/?utm_source=mastodon&utm_medium=social&utm_campaign=mastodon.social #letsencrypt #proxyserver #reverseproxy

#Invoice #Ninja als Alternative zu Lexware und anderen #Abrechnungsportalen.

#Rechnungsstellung leicht gemacht: Wie ich als #Technik-Blogger mit Invoice Ninja via #Docker und #Nginx kostengünstig professionelle Rechnungen erstelle. Ideal für Selbsthoster\:innen, die eine freie und flexible Lösung suchen.

https://gnulinux.ch/invoice-ninja-als-alternative-zu-lexware-und-anderen-abrechnungsportalen