12 событий апреля, которые нельзя пропустить

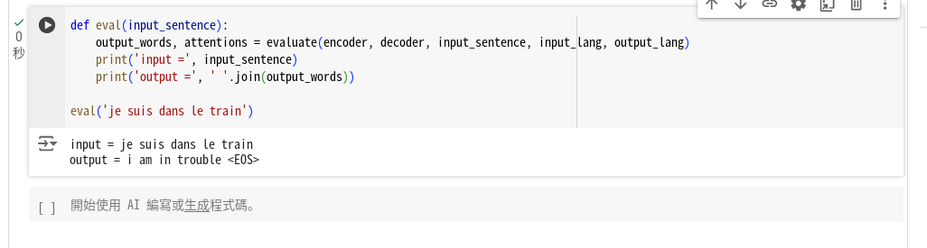

Мы собрали для вас серию открытых уроков, которые пройдут в апреле и помогут не просто разобраться в сложных темах, а применить знания на практике. Будущее AI агентов на основе LLM, Prometheus для мониторинга, как избежать хаоса в IT-проектах и как обучить модель понимать языки — на эти и не только темы поговорим с экспертами в IT. Рассмотрим реальные кейсы, обсудим опыт и получим понимание того, как внедрять эти технологии в проекты.

https://habr.com/ru/companies/otus/articles/899644/

#AI_агенты #Scrum #seq2seq #автоматизация_тестирования #Docker #Apache_Kafka #Смартконтракты #data_science #prometheus