Попробовал как играют современные нейронки в #

Го на домашнем десктопе с простенькой видяхой, open source варианты, свободные.

Затем, что современные значимые и серьёзные успехи «искусственного интеллекта» пошли в массы с эпопеи вокруг #

AlphaGo, которое за три-четыре года развития изменилось сильно и в размерах и скорости работы, хорошо задокументировано и всячески изучено.

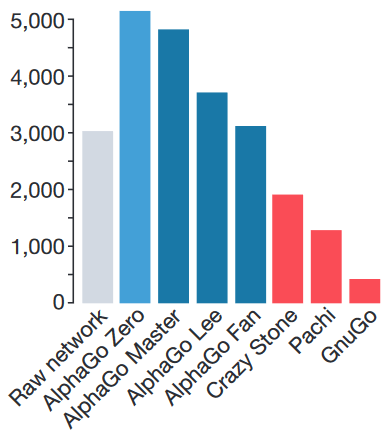

Так вот, прошло изрядно лет уже с тех пор как AlphaGo остановилось в развитии, достигнув апогея (AlphaGo Zero), и где свободные аналоги? Пусть и заточенные именно для игры в Го и только для неё.

Отыскался

движок KataGo, вроде по тем же принципам, что и последние варианты AlphaGo, с уже обученными сетками, которые регулярно обновляются дообучаясь.

#

KataGo вариант использующий видеокарту, #

OpenCL, сходу не завёлся — пришлось погонять сперва вариант для #

CPU, чтобы подобрать GUI для использования движка: #

Sabaki, #

q5Go.

Заценив работу движка и шум системы охлаждения процессора — уже переключился на OpenCL-вариант. Для чего пришлось сносить из системы всё про #

Mesa и ставить «opencl-amd» на #

ArchLinux.

И оно того стоит, не только потому что реально быстрее работает в плане ходов да подсчёта всякой аналитики, но главное комп перестал надрываться работой системы охлаждения. Памяти на видяхе KataGo отжирает порядка гигабайта, может полутора. Однако, у меня и режим работы выбран с дополнительной нейронкой для подражания человеку в плане манеры игры, ссылки на этот вариант работы движка есть в readme.

Планшеты и мобильники?Для #

android тоже есть вариант KataGo — зовётся #

BadukAI, доступен и в Google'ом и Amazon'овском маркете

ссылка, а так же через альтернативные клиенты. Если в #

Aurora не работает вдруг поиск, то ссылку ту можно открыть/отправить в #

Aurora и откроет спокойно.

Что на счёт GUI?Прежде чем гонять движки разные, имеет смысл опробовать

GNU Go — это который про игру в #

Го с компьютером, оно же «Бадук» у корейцев и «Вэйци» у китайцев (откуда якобы и пришло). GNU Go есть у всех #

linux в репозиториях и доступен любому желающему поиграть в Го через #

Kigo, #

qGo, #

q5Go, #

Sabaki, #

KaTrain, #

Lizzie.

Если выбранная GUI'шная софтина работает с GNU Go, то будет работать (должны) и со всякими другими движками для игры в Го, потому что используется gtp режим.

Сложность лишь в том, что порой GNU Go путают с GNU'шным компилятором Golang — который называется иначе:

GCC Go.

Альтернативы нейронкам?Есть вариант сугубо на базе #

MCTS (который Monte Carlo tree search) — ощутимо получше GNU Go и более относительно современное — #

Pachi Работает на десктопе #

Pachi серьёзно нагружая систему, а так же имеет кучу заморочек по настройкам. Например, на тему подключения дополнительного движка ради нормальной игры в #

joseki, не сказать чтобы весёлый вариант.

Однако, если ставить на android-устройство, то существует небольшой

вариант, размером менее трёх мегабайт, который вполне шустро работает.

#

AI #

ИИ #

games #

gaming #

го #

igo #

baduk #

бадук #

weiqi #

вэйци #

lang_ru @

Russia