Do you want to Master Prompt Engineering? Here’s my overview on how to Prompt like a Pro!

#promptEngineering #ConversationalAI #GenerativeAI #AIPrompts #PromptDesign #ZeroShot #FewShot #ChainOfThought #AIForBusiness #AIEdge #AIProductivity #WorkSmarter #DigitalTransformation #TechLeadership #FutureOfWork #Innovation #LinkedInCreators #AIInsights #TechTips #CareerGrowth

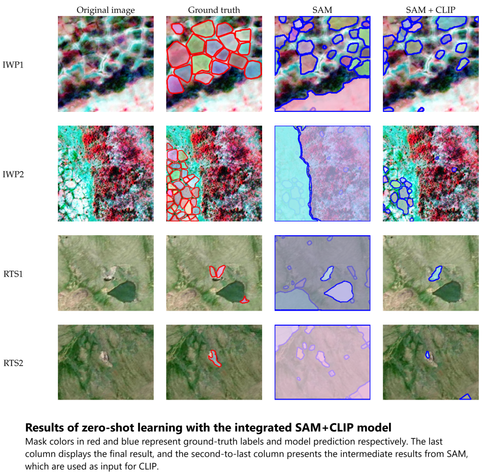

![maps/images - Results from knowledge-embedded learning with SAM. The results are those after fine-tuning. The images are the same as those in [other figure.]](https://files.mastodon.social/cache/media_attachments/files/113/953/101/638/955/634/small/be8478f6302eb876.png)